Sommaire

GeForce RTX 3090

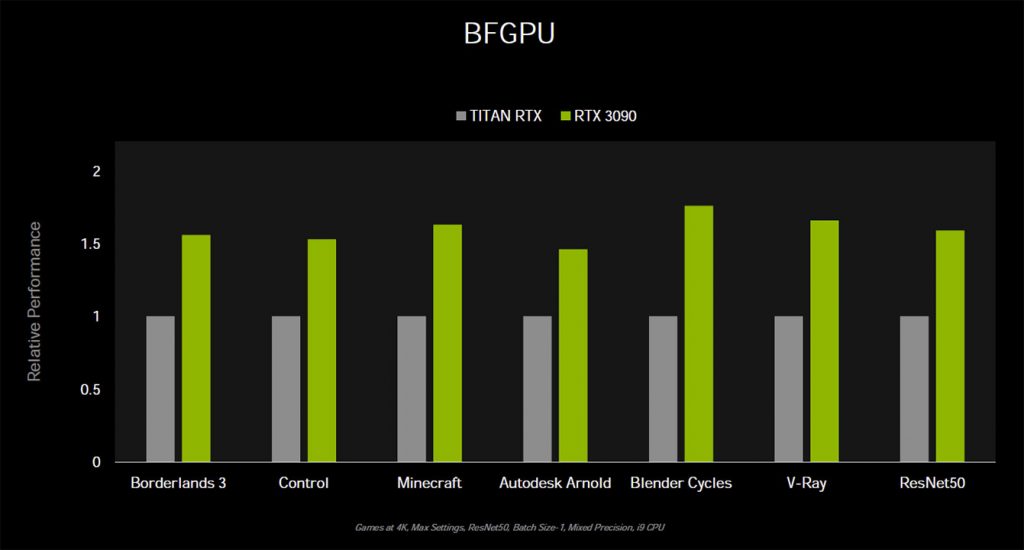

La GeForce RTX 3090 sera le modèle le plus haut de gamme de la nouvelle architecture Ampere. Elle se positionne sur le segment « halo » habituellement occupé par la marque TITAN. Ceci pourrait également signifier qu’il n’y aura probablement pas de TITAN Ampère. La carte s’affiche à 1 549 € et sera disponible le 24 septembre. Dans les diapositives et présentations marketing de NVIDIA, elle a été largement comparée au TITAN RTX.

La RTX 3090 utilise une puce GA102. Cette dernière comprend 10 496 cœurs CUDA répartis sur 82 SM (41 TPC), 82 cœurs RT, 328 cœurs tenseurs, 328 TMU et probablement 112 ROP. La puce exploite au maximum l’interface mémoire GDDR6X de 384 bits, en tirant 24 Go de mémoire à 19,5 Gbps. Ceci correspond à 940 Go/s de bande passante mémoire. NVIDIA évalue la puissance de la carte à 350 W. Non seulement cette carte est conçue pour afficher de la 4K à des taux de rafraîchissement élevés ; mais elle est également capable d’afficher de la 8K.

NVIDIA revendique des gains de performance de 50 à 70 % pour le RTX 3090 par rapport au TITAN RTX à 2 749 €.

GeForce RTX 3080

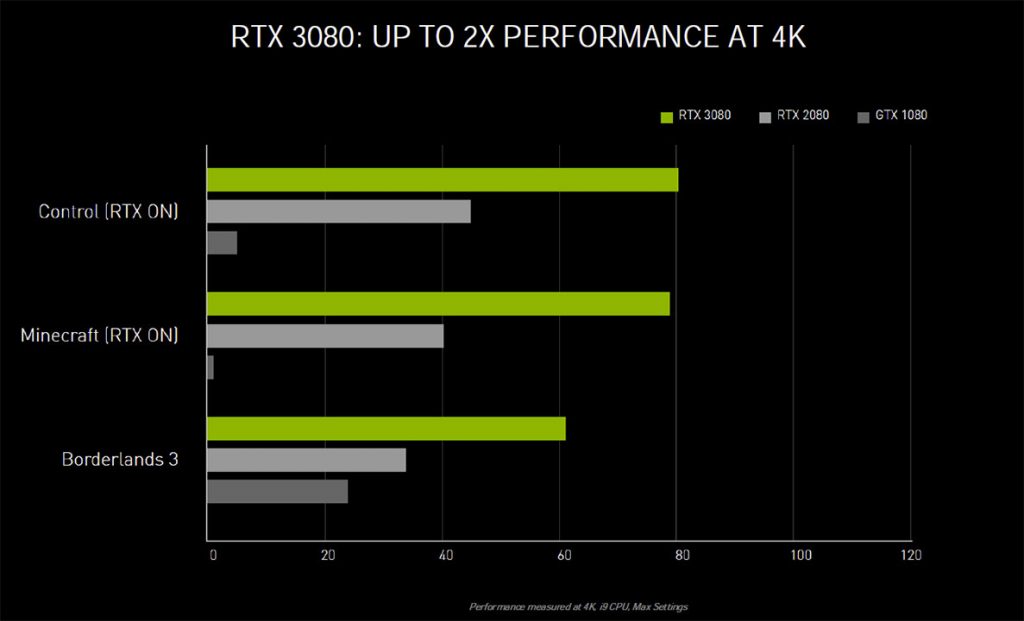

La GeForce RTX 3080 est le deuxième produit à être lancé sur la nouvelle architecture. Pour une raison inconnue, NVIDIA la qualifie de « nouveau vaisseau amiral ». La RTX 3080 s’affiche à 719 € et sera disponible le 17 septembre. Elle succède au RTX 2080 et au RTX 2080 Super de la génération précédente. Elle se base aussi sur la puce GA102, donc la même puce que la RTX 3090. La RTX 3080 est dotée de 8 704 cœurs CUDA répartis sur 68 SM (34 TPC), 68 cœurs RT, 272 cœurs tenseurs, 272 TMU et 96 ROP. La puce est dotée d’une interface mémoire GDDR6X de 320 bits qui gère 10 Go de mémoire à 19 Gbps. Ceci correspond à une bande passante mémoire de 760 Go/s. NVIDIA évalue la puissance de la carte du RTX 3080 à 320 W. L’application cible est le jeu UHD 4K.

NVIDIA affirme que le RTX 3080 offre des gains de performance massifs près de deux fois supérieurs à la RTX 2080 de la génération précédente. Et ceci avec une résolution UHD de 4K.

GeForce RTX 3070

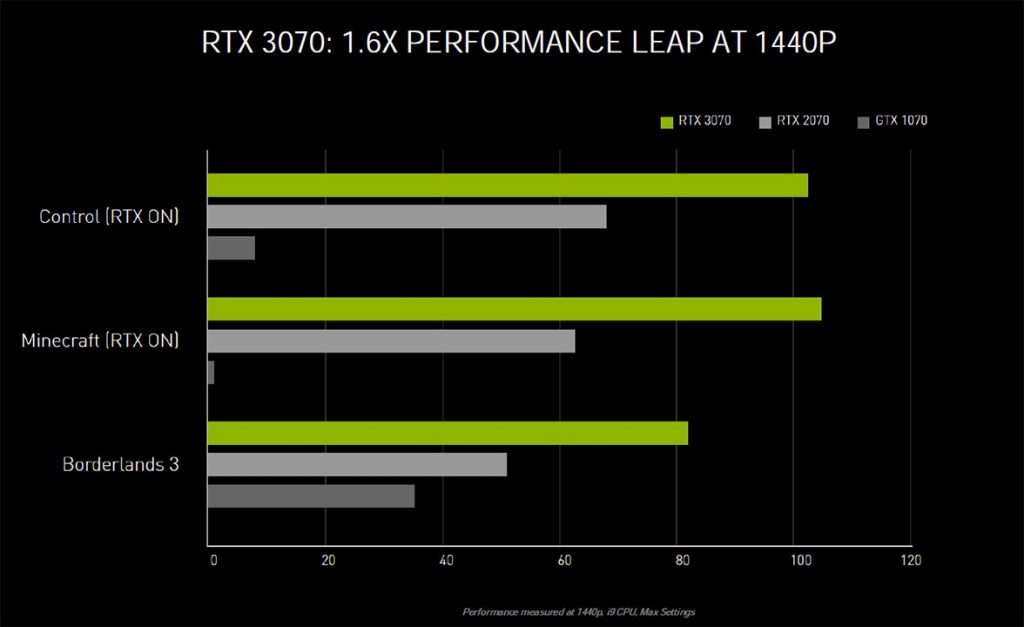

Le lancement de la GeForce RTX 3070 est prévu en octobre 2020. Elle devrait attirer un public plus large avec son prix de départ de 519 €. Elle se destine aux jeux à taux de rafraîchissement élevé en 1440p. Bien que NVIDIA affirme que cette carte est « plus rapide que la RTX 2080 Ti », qui est une carte pour la 4K.

Pour l’instant, nous n’avons aucune information officielle sur la puce utilisée par la RTX 3070. Toutefois, il est probable qu’il s’agisse du GA104. NVIDIA indique que son noyau CUDA est 5 888 fois plus élevé que celui du TITAN RTX. Ces cœurs CUDA sont répartis sur 46 SM (23 TPC). Ils comportent 46 cœurs RT, 184 cœurs tenseurs, 184 TMU et probablement 64 ROP. Elle est dotée d’une interface mémoire GDDR6 classique de 256 bits de large, avec 8 Go de mémoire. Il reste à voir si NVIDIA la fait fonctionner à 14 Gbps ou à 16 Gbps. NVIDIA évalue la puissance de la carte du RTX 3070 à 220 W.

Le RTX 3070 promet un « saut » de performance de près de 60% par rapport au RTX 2070. Ceci lui permettrait non seulement de dominer le segment 1440p, mais aussi d’être capable de jouer en 4K UHD. En effet, si on ajoute 60% de performance à la RTX 2070, on s’approche de la RTX 2080 Ti.

Architecture des GeForce Ampere

« Ampère » représente la 2ème génération de la technologie GeForce RTX de NVIDIA. Le raytracing en temps réel a fait ses débuts dans les cartes graphiques grand public en avance sur son temps. En effet, on le jugeait trop gourmand en calculs, même avec un grand nombre de cœurs de shaders programmables. NVIDIA RTX a résolu ce problème en introduisant un nouvel hybride de raytracing.

En effet, une grande partie de la scène 3D est restituée par des rendus graphiques traditionnels alors que certains éléments bénéficient de la technologie RT. Ils sont alors tracés par des rayons. Pour ce faire, NVIDIA a dû développer des innovations qui minimisent le nombre de rayons nécessaires au raytracing. Les RTX s’appuient fortement sur un traitement du bruit basé sur l’intelligence artificielle. Il a donc fallu développer du matériel spécialement conçu (et parfois à fonction fixe), comme les noyaux RT. Ils ont à charge le traitement des BVH et des intersections. Les noyaux tenseurs, eux, accélèrent les multiplications matricielles utilisées par l’intelligence artificielle.

Avec « Ampere », nous voyons l’introduction de nouveaux multiprocesseurs de streaming, le principal moteur de shader programmable des GPU NVIDIA. Les cœurs RT passent à la 2e génération et les cœurs tensorisés à la 3e génération. Les cœurs tensorisés sont antérieurs à « Turing » et ont été introduits avec « Volta ». Le principal moteur de ces trois produits n’est pas seulement l’amélioration générationnelle des performances de traitement de trame. C’est aussi la réduction de l’impact sur les performances avec l’utilisation du Raytracing. La première vague de cartes graphiques NVIDIA GeForce Ampere comprend la GeForce RTX 3080 et la RTX 3090. Il est surprenant que les deux cartes soient basées sur la même puce « GA102 ». NVIDIA a fait le choix de ne pas appuyer sa carte GeForce RTX 3080 sur une puce moins performante.

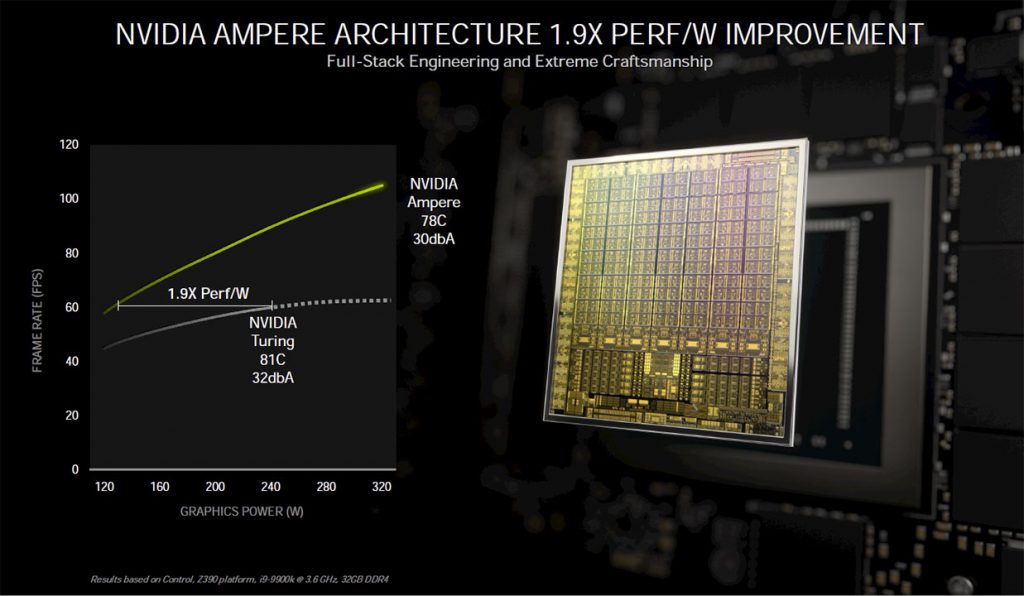

Un avantage du passage à 8 nm serait peut-être un gain massif sur le rapport performances / énergie. NVIDIA affirme que les performances en watts ont augmenté de 90 %. Ceci signifie que ses cartes ne se contentent pas d’une augmentation de la puissance de la carte.

La puce GA102

La puce GA102 de NVIDIA est produite sur le procédé de gravure de 8 nanomètres « 8N » de Samsung. Ce procédé offre des densités de transistors et un rapport de puissance comparables au procédé TSMC N7. NVIDIA utilise ce dernier pour le processeur A100 Tensor Core. La puce reçoit 28 milliards de transistors. Dans sa version RTX 3080, elle offre un débit de calcul brut pouvant atteindre 30 TFLOP FP32, 58 TFLOP de ray-tracing et 238 TFLOP de tenseur.

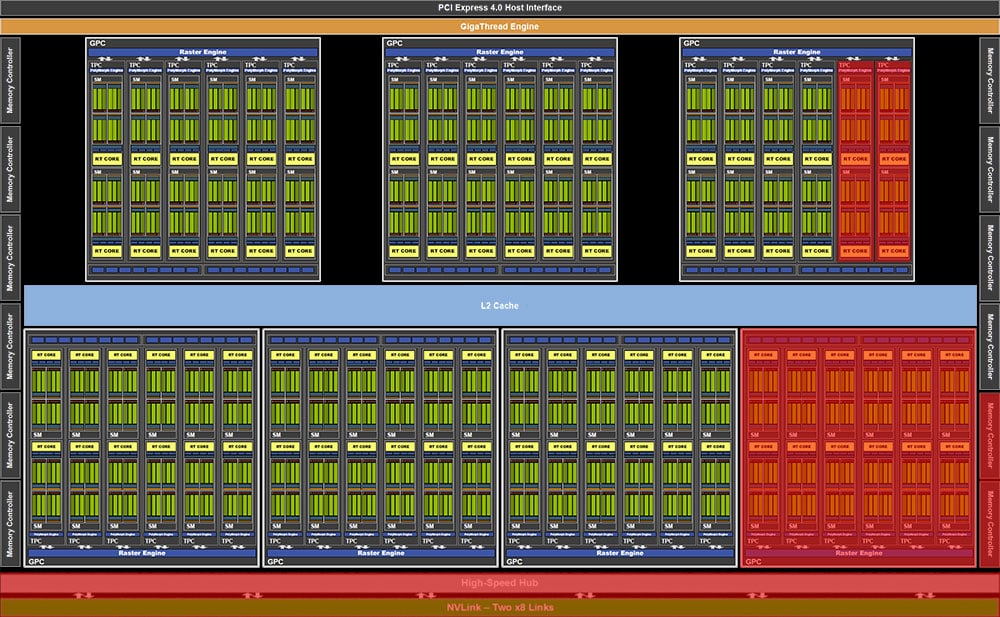

GeForce RTX 3080

Ci-dessus se trouve un schéma fonctionnel de l’architecture du GA102 tel qu’il est implémenté sur le RTX 3080. La puce GA 102 possède 8 704 cœurs CUDA répartis sur 68 multiprocesseurs de streaming (SM). C’est une augmentation stupéfiante de 183 % par rapport au RTX 2080 Super. Cette augmentation est en plus combinée aux améliorations de l’IPC au niveau des SM. Il en résulte une augmentation massive de 172 % du débit du FP32 par rapport à la RTX 2080 Super (11 TFLOP contre 30 TFLOP). Les groupes de deux SM, appelés « texture processing clusters » (TPC), restent la plus petite unité de segmentation de l’architecture Ampere. Le RTX 3080 comporte 34 TPC (68 SM) répartis sur six grappes de traitement graphique (GPC).

Sur la RTX 3080, au niveau le plus extérieur, le GA102 est doté d’une interface hôte PCI-Express 4.0 x16. On trouve également le GigaThread qui répartit et coordonne le travail entre les GPC. Le tout est complété par un cache L2. Celui-ci sert de place pour les GPC et d’une interface mémoire GDDR6X de 320 bits. Sur le RTX 3090, cette interface mémoire est élargie à 384 bits. Il y a 41 TPC répartis sur un plus grand nombre de GPC. Le RTX 3080 ne dispose pas d’une interface multi-GPU NVLink, alors que le RTX 3090 en a une. NVIDIA a changé le connecteur NVLink pour économiser de l’espace sur le PCB.

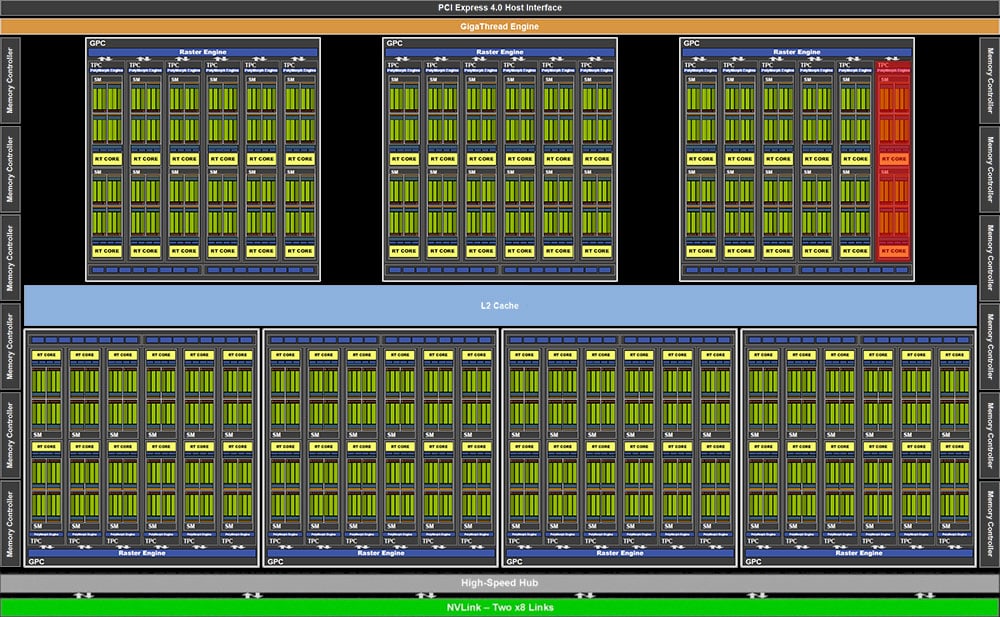

GeForce RTX 3090

Voici le schéma fonctionnel du silicium GA102 présent sur la RTX 3090. Il possède l’interface mémoire complète de 384 bits du GA102 ainsi que tous ses GPC. Mais un TPC (deux SM) est découpé pour une meilleure rentabilité. Avec 82 SMs activés, chacun avec 128 cœurs CUDA, la RTX 3090 atteint plus de 10 000 (10 490) cœurs CUDA. Un autre composant non disponible sur le RTX 3080 est l’interface NVLink de la puce. À chaque nouvelle génération, NVIDIA a retiré le SLI des segments supérieurs de sa gamme de produits. En effet, le multi-GPU est une technologie en voie de disparition.

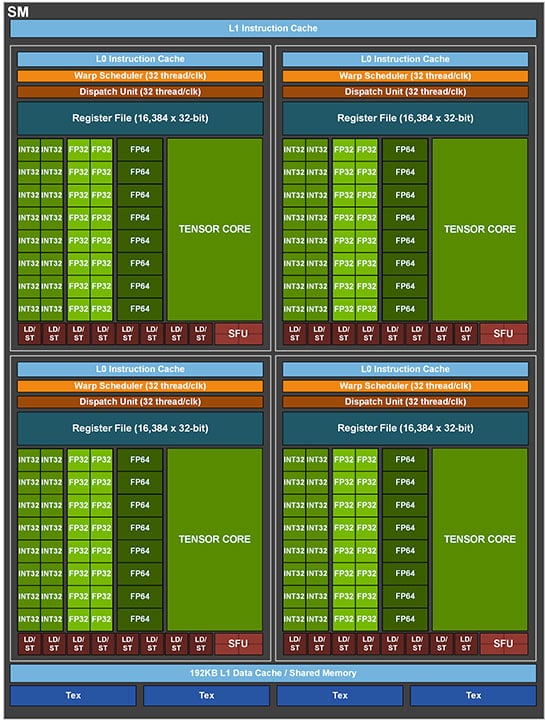

Le nouvel Ampère SM

Le multiprocesseur de streaming (SM) est le domaine dans lequel NVIDIA a mis l’essentiel de ses efforts d’ingénierie. Il s’agit du composant clé du GPU pour le traitement des données. NVIDIA affirme que l’Ampère SM a deux fois plus de puissance de calcul que le Turing SM. Nous avons toujours quatre programmateurs de distorsion. Ceux-ci échelonnent les charges de travail pour les composants SIMD, mais chaque sous-unité possède maintenant 32 cœurs CUDA FP32. Parmi ceux-ci, 16 peuvent effectuer des opérations mathématiques FP32+INT32 en simultané.

C’est différent sur l’Ampère SM du processeur scalaire A100 Tensor Core (photo ci-dessus pour comparaison). Celui-ci comporte seize cœurs FP32 et INT32, chacun, et huit cœurs FP64 (double précision). Chaque sous-unité dispose en outre d’un cœur de tenseur de troisième génération, de quatre unités de stockage de charge et d’un fichier de registre. Quatre de ces sous-unités totalisent 128 cœurs CUDA FP32 sur le GeForce Ampere SM, dont 64 peuvent gérer des opérations INT32+FP32 simultanées. Chaque SM comprend un noyau RT de deuxième génération, un cache de données L1 de 128 Ko et quatre TMU.

Grâce à un nouveau chemin de données, la GeForce Ampere SM offre des performances deux fois supérieures à celles du FP32, soit 128 opérations de fusion et d’ajout multiples (FMA) par horloge. Le noyau RT de 2e génération est censé offrir des taux de triangulation deux fois plus élevés que la génération précédente. Quant au nouveau noyau tenseur de 3e génération, il offre un débit mathématique deux fois plus élevé grâce à la technologie de pointe de rareté introduite avec Ampere.

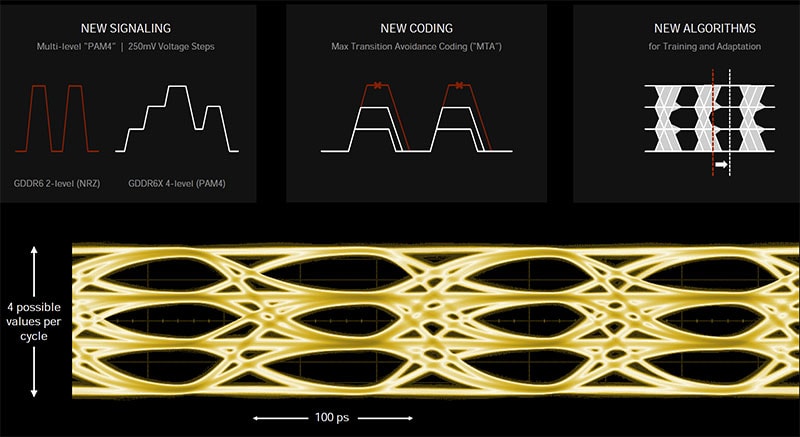

Mémoire GDDR6X

NVIDIA s’est associé à Micron Technology pour développer la GDDR6X, qui semble être une technologie de mémoire exclusive à NVIDIA. La GDDR6X s’appuie sur la norme GDDR6 du JEDEC en tirant parti de la signalisation de la couche physique PAM4 (modulation d’amplitude d’impulsion 4) à plusieurs niveaux, qui permet de transmettre quatre valeurs possibles par cycle. Rappelez-vous quand on vous disait que le binaire n’est que deux valeurs, « on » ou « off », « un » et « zéro ». Eh bien, cela a changé – le PAM4 transmet jusqu’à quatre niveaux de tension différents afin de multiplier par deux les données à chaque cycle d’horloge.

Le défi consiste à éviter la dégradation du signal afin que les niveaux de tension puissent être clairement distingués. C’est assez facile avec « on » et « off », mais il est plus difficile de distinguer quatre niveaux de signal différents. C’est pourquoi un nouveau codage est utilisé pour les données. Au lieu de transmettre directement les valeurs brutes, un 0 comme absence de tension et un 3 comme tension maximale à chaque fois, le schéma de codage MTA (maximum transition avoidance) choisit les niveaux de tension en fonction du niveau précédent, de sorte que la différence entre les horloges ne soit pas une pleine oscillation de tension.

Enfin, NVIDIA a amélioré son algorithme d’entraînement dans le contrôleur de mémoire, qui est désormais plus robuste. Il va maintenant se recycler de temps en temps et peut s’adapter aux changements de l’environnement, comme la température ou les interférences EMI.

Grâce à cela, NVIDIA a pu augmenter les débits de données, jusqu’à 19,5 Gbps pour la RTX 3090 et 19 Gbps pour la RTX 3080. Pour le RTX 3090, cela se traduit par des largeurs de bande mémoire approchant les 940 Go/s. On est proche des solutions de mémoire beaucoup plus coûteuses, comme le HBM2 4096 bits.