Intel est sur le point de révolutionner le marché des processeurs pour ordinateurs portables avec son tout nouveau SoC Lunar Lake. Fruit d’un énorme travail d’optimisation de l’architecture, de l’intégration et de la gravure, Lunar Lake promet un bond générationnel en termes de performances et d’efficacité énergétique.

Pour réaliser cette prouesse, Intel a mis les bouchées doubles en travaillant main dans la main avec le fondeur TSMC, qui lui fournit son procédé de gravure en 3 nm de dernière génération. Cela permet à Lunar Lake d’intégrer plus de transistors dans un espace réduit, tout en diminuant leur consommation. C’est la clé pour obtenir des cœurs CPU plus performants, une partie graphique plus véloce et un processeur dédié à l’intelligence artificielle capable de prouesses.

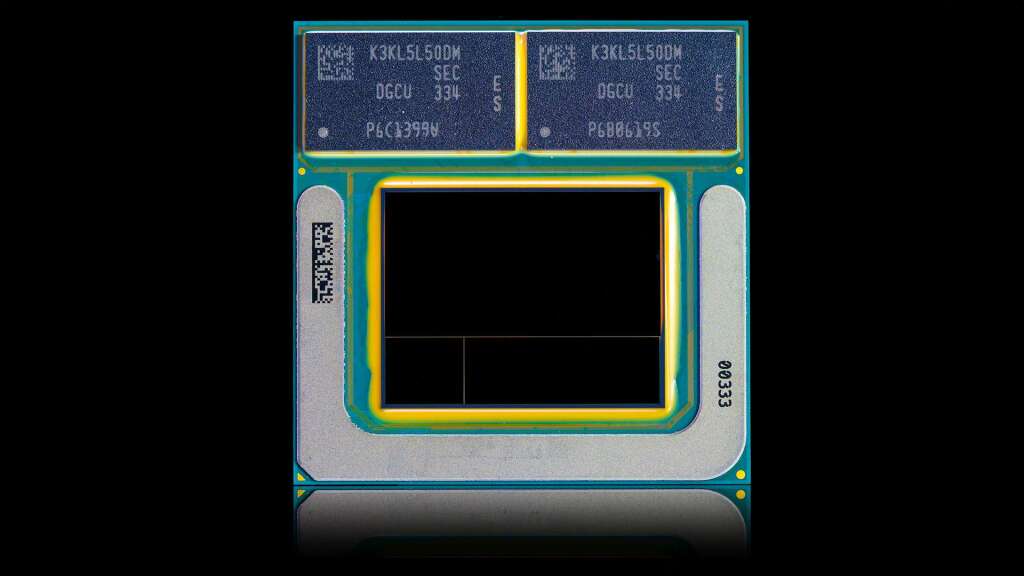

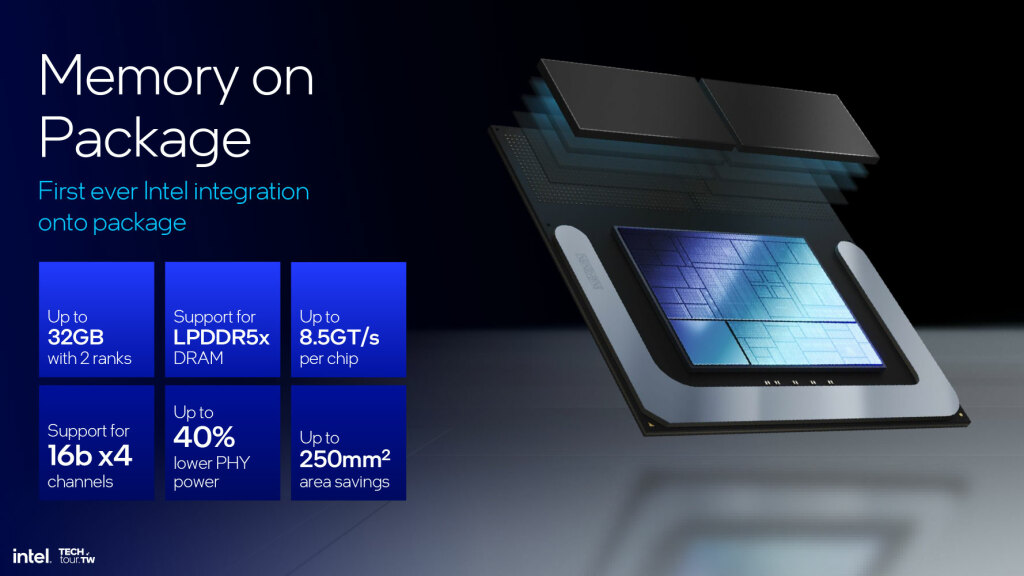

Lunar Lake marque aussi une étape importante dans l’évolution des SoC x86. Pour la première fois, Intel intègre la mémoire DRAM directement dans le package, une approche inaugurée par Apple sur ses puces ARM. Les bénéfices sont multiples : une bande passante mémoire accrue, une latence réduite et un gain de place sur la carte mère.

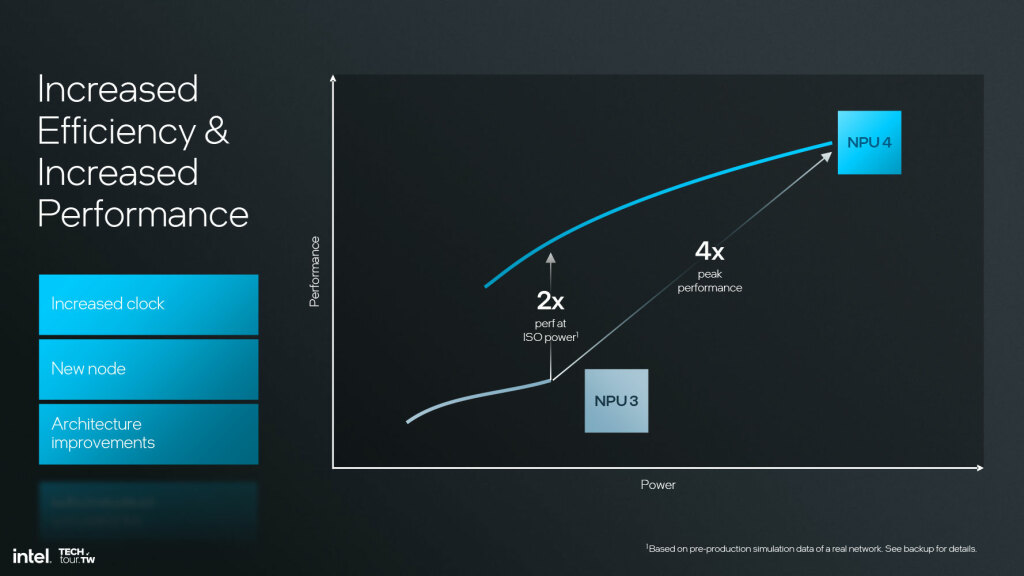

Mais les innovations de Lunar Lake ne s’arrêtent pas là. Intel a entièrement revu l’architecture de ses cœurs CPU haute performance, avec au programme plus d’IPC, plus de MHz et une meilleure gestion de l’énergie. Les nouveaux cœurs efficients sont si rapides qu’ils dépassent en performance les anciens cœurs haute performance, tout en consommant une fraction de leur énergie. Le GPU intégré fait le grand saut vers l’architecture Xe2, dérivée des cartes graphiques dédiées Arc d’Intel. Et le processeur neuronal multiplie sa puissance par plus de 4.

Lunar Lake se pose ainsi en nouveau champion de l’efficacité énergétique, sans compromis sur les performances. De quoi permettre aux ultra-portables sous Windows 11 de 2024 de proposer une expérience utilisateur premium, avec une grande réactivité et une autonomie de très haut vol. Tour d’horizon de cette petite bombe de technologie.

Intel Lunar Lake : Construction et vue d’ensemble

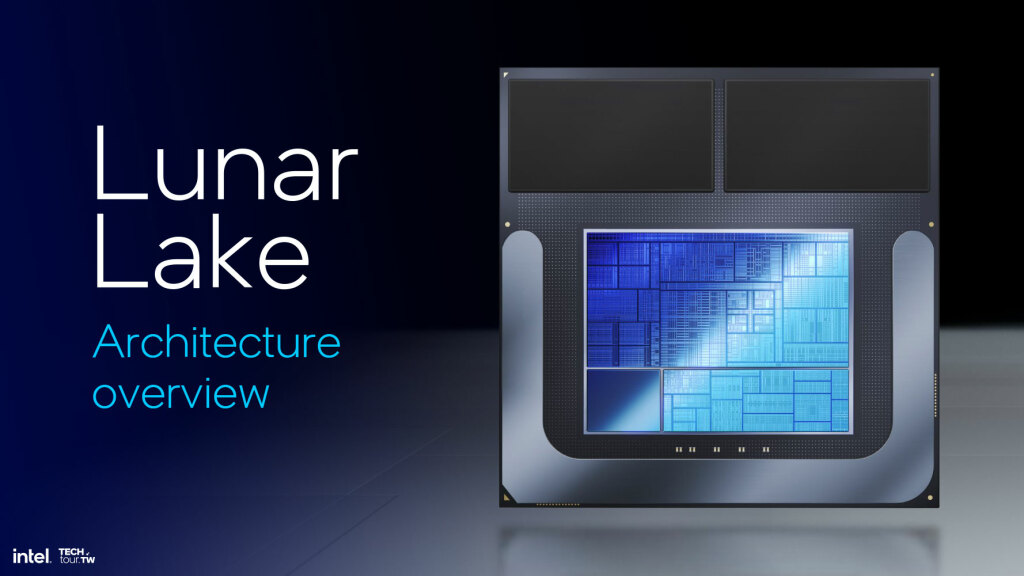

Depuis quelques années, Intel s’est engagé dans une refonte complète de l’architecture de ses processeurs. L’objectif : s’adapter aux nouveaux usages et défis du monde mobile, où l’efficacité énergétique est critique. Pour cela, le géant des semi-conducteurs a fait le pari de découper ses SoC en plusieurs « tuiles » spécialisées, interconnectées grâce au packaging 3D Foveros.

Lunar Lake franchit une nouvelle étape dans cette approche, avec une simplification du nombre de tuiles. Là où la précédente génération Meteor Lake nécessitait 4 tuiles distinctes (Compute, SOC-LP, GPU, et I/O), Lunar Lake n’en compte plus que deux :

- La tuile « Compute Tile », gravée par TSMC en 3 nm (N3B). C’est le cœur du SoC, qui intègre les cœurs CPU haute performance Lion Cove et efficient Skymont, le GPU Xe2, le NPU dédié à l’IA, ainsi que les contrôleurs mémoire et fabric.

- La tuile « Platform Controller » (PCT), gravée en 6 nm par TSMC (N6). Elle s’occupe de toute la connectivité et des I/O, avec notamment le support des standards PCIe 5.0, Thunderbolt 4, et Wi-Fi 7. Une nouveauté pour ce type de tuile chez Intel.

Sur le package viennent se greffer deux puces LPDDR5X-8500 pour un total allant jusqu’à 32 Go de RAM. C’est une petite révolution pour les PC x86, rendue possible par le RDL (Redistribution Layer) du package Foveros, qui fait office d’interposeur.

En résulte un SoC compact et hautement intégré, capable de tenir dans une enveloppe thermique mobile de 15W. Malgré cette contrainte, Intel annonce une puissance de calcul d’intelligence artificielle combinée pouvant grimper jusqu’à 120 TOPS (billions d’opérations par seconde). Une valeur largement supérieure à ce que proposent les SoC concurrents comme l’Apple M2 ou les récents Snapdragon 8cx Gen 3.

Ce score impressionnant est obtenu en additionnant les 4 TOPS des cœurs CPU, les 48 TOPS du NPU dédié, et jusqu’à 68 TOPS provenant du GPU. Le secret de ce dernier ? L’intégration d’unités XMX dédiées à l’accélération des réseaux de neurones, une approche héritée des GPU Xe-HPG d’Intel (famille Alchemist).

Mais toute cette puissance ne servirait à rien sans une gestion intelligente. C’est le rôle du contrôleur d’énergie intégré dans la tuile PCT, qui surveille en temps réel l’activité des différents blocs du SoC. En fonction des besoins de la charge de travail, il peut ainsi ajuster finement la fréquence et la tension de chaque domaine, voire couper complètement l’alimentation des parties inutilisées. Ce contrôleur travaille main dans la main avec le « Thread Director », une IP développée par Intel depuis la 12e génération de Core (Alder Lake).

Ce petit chef d’orchestre matériel est capable d’analyser en temps réel le comportement des threads, et de les assigner dynamiquement sur les cœurs les plus adaptés (performance ou efficients). Il peut même suggérer au système d’exploitation d’activer un mode « performance » ou « basse consommation » en fonction du scénario.

Avec toutes ces technologies, Lunar Lake vise clairement à reprendre la main sur le marché très disputé des PC ultra-mobiles hautes performances. Le SoC sera décliné en deux familles de produits : la série « U » avec un TDP de 15W pour les ultrabooks 13-14 pouces, et la nouvelle série « V » culminant à 45W pour le haut de gamme. Intel évoque plus de 80 design en préparation chez ses partenaires.

Cœurs CPU haute performance (P-Core) Lion Cove

Depuis son virage vers une architecture hybride, Intel alterne entre évolution et révolution sur ses cœurs haute performance. Après Raptor Lake et son cœur Raptor Cove (basé sur Golden Cove avec quelques optimisations), place à du neuf avec Lunar Lake et les cœurs Lion Cove.

Le défi était de taille pour les architectes d’Intel : augmenter significativement les performances, mais sans exploser l’enveloppe énergétique, le nerf de la guerre sur les plateformes mobiles. Pour cela, il a fallu revoir le cœur en profondeur, en commençant par un douloureux sacrifice : celui de l’Hyper-Threading.

Sur les précédentes générations, cette technologie permettait de gérer deux threads logiques par cœur physique, offrant un gain de performances de 30% en moyenne pour 20% de consommation supplémentaire. Un ratio intéressant en apparence, mais qui imposait de maintenir les cœurs haute performance actifs même pour des tâches légères. Or sur un processeur hybride comme Lunar Lake, ces petits travaux peuvent avantageusement être délégués aux cœurs efficients, nettement moins gourmands.

Intel a donc pris la décision de retirer purement et simplement l’Hyper-Threading sur les cœurs Lion Cove pour sa plateforme mobile. Cela permet d’économiser 15% de superficie en supprimant toute la logique de partage des ressources, mais aussi de simplifier le contrôle de l’énergie. Lorsqu’un cœur haute performance n’a plus de thread à traiter, il peut ainsi être intégralement mis en veille, réduisant sa consommation à presque zéro.

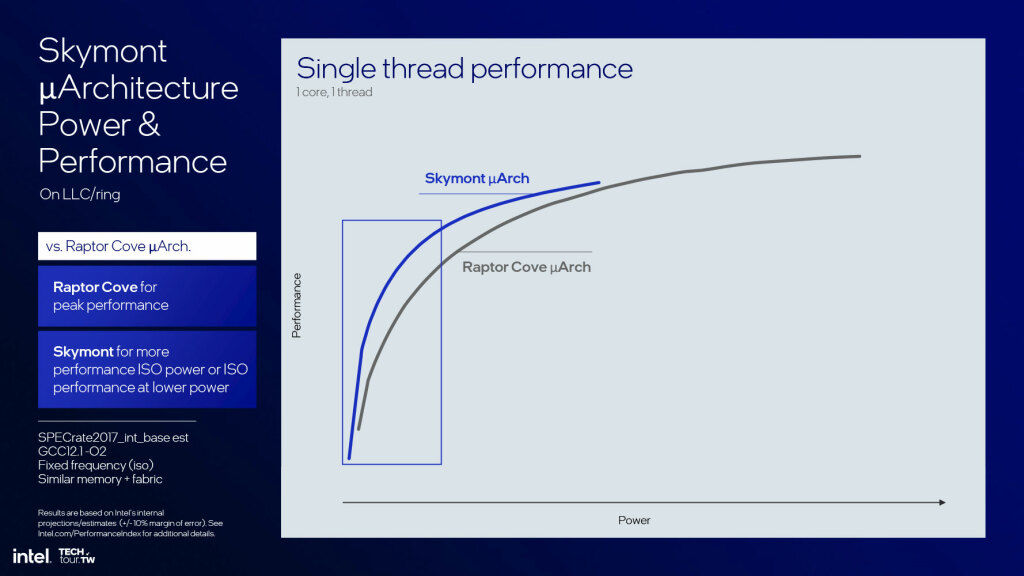

Cette évolution est rendue possible par la montée en puissance des cœurs efficients Skymont (voir plus loin), qui atteignent désormais un niveau de performance similaire aux anciens cœurs Raptor Cove. Intel peut donc se permettre de leur confier plus de tâches sans impacter l’expérience utilisateur. Les cœurs Lion Cove sont ainsi réservés aux scénarios demandant un maximum de performance sur un seul thread, comme le gaming, la création de contenu ou la compilation.

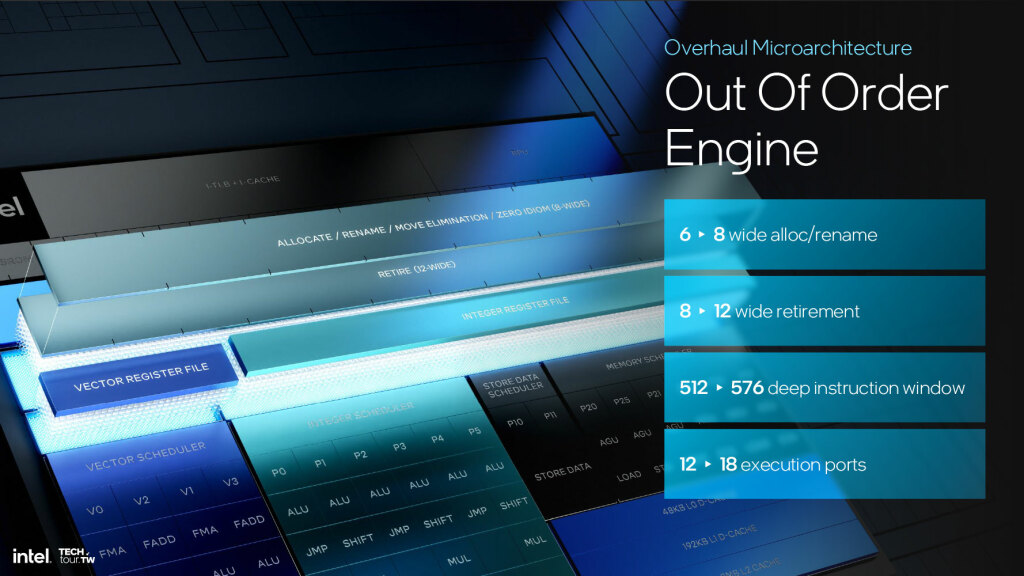

Pour compenser la perte de l’Hyper-Threading, les ingénieurs ont travaillé à augmenter le débit et la vitesse d’exécution du pipeline. Cela commence dès le front-end, avec un prédicteur de branchements 8 fois plus grand que la précédente génération. Le décodeur gagne également en bande passante, avec une largeur de 8 instructions par cycle (contre 6 sur Raptor Cove). Le cache de micro-opérations passe à 12 µOps délivrées par cycle, soit 50% de mieux qu’auparavant. Sa capacité grimpe à 5250 entrées, afin de pouvoir absorber un flux d’instructions plus important. Autant d’améliorations qui permettent de mieux exploiter les unités d’exécution du cœur.

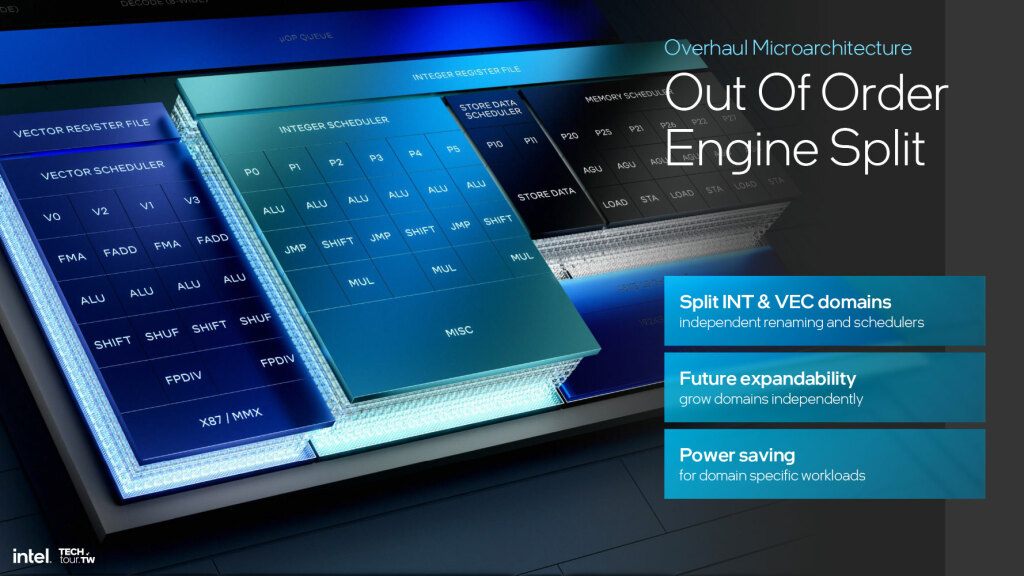

Car c’est au niveau du back-end que les changements sont les plus visibles. Intel a opté pour un découplage des unités de calcul entier (ALU) et vectoriel (SIMD), chacune ayant son propre planificateur. Ce découpage permet une meilleure scalabilité, et de mieux adapter les ressources à chaque type de charge. Ainsi, Lion Cove intègre 6 ALU entières pour 3 ports « Jump », 3 ports « Load » et 2 ports « Store ». De son côté, la partie vectorielle reçoit 4 ALU 256-bits, ainsi que 2 multiplication-addition (FMA) 256-bits par cycle.

Au total, le nombre de ports d’exécution grimpe à 18 (contre 12 sur la génération précédente), pour un maximum théorique de 48 FLOPS par cycle en simple précision (FP32). A noter que Lion Cove ne supporte plus officiellement les instructions AVX-512, jugées trop énergivores. La compatibilité est toutefois maintenue pour assurer le bon fonctionnement des applications existantes.

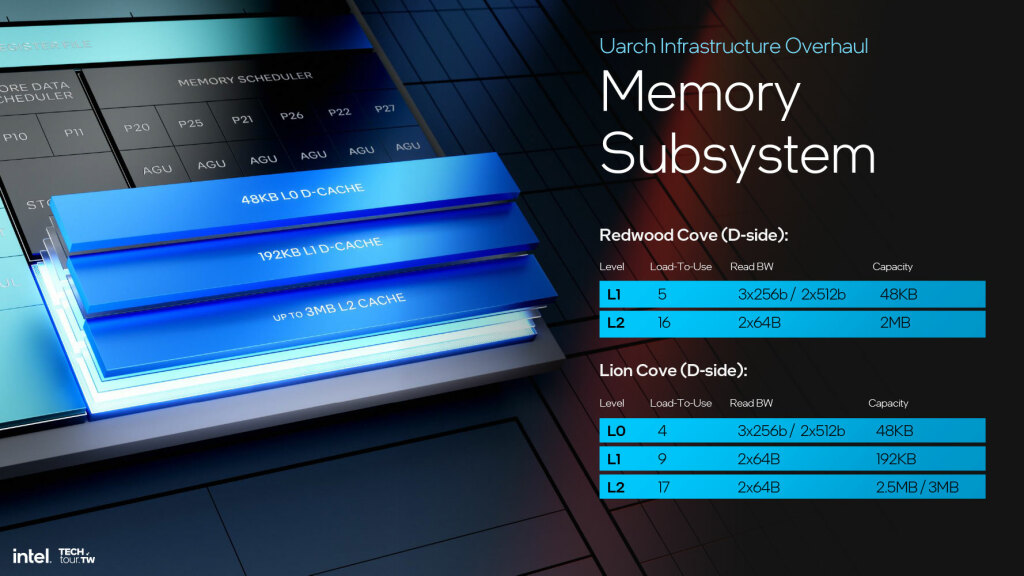

Toutes ces unités de calcul se partagent un fichier de registres élargi, avec 18 registres vectoriels 512-bits (ZMM0-ZMM17) et 10 registres d’usage général 64-bits (R14-R23). Les accès mémoire sont accélérés grâce à un cache de niveau L1 de 192 Ko (64 Ko pour les instructions, 128 Ko pour les données) et 2,5 Mo de cache L2 privé par cœur. Mais la vraie star est le nouveau cache L0. Physiquement proche des ALU, il sert de réservoir ultra-rapide pour les données fréquemment utilisées.

Avec 48 Ko de capacité et une latence réduite à seulement 4 cycles, il permet d’exploiter au mieux le parallélisme d’instructions. C’est d’ailleurs le seul niveau de cache duquel les exécuteurs vectoriels 256-bits peuvent lire 3 opérandes par cycle.

Le cache L3 partagé entre les cœurs atteint quant à lui 12 Mo pour la version mobile de Lion Cove, avec une latence moyenne de 17 cycles. Les accès sont gérés par un contrôleur mémoire (IMC) compatible LPDDR5X-8500, pour une bande passante théorique de 68 Go/s. Pour orchestrer toute cette symphonie, la partie « out-of-order » du pipeline a été considérablement renforcée. La fenêtre d’instructions passe ainsi à 576 entrées (contre 512 auparavant), avec 10 étages de ré-ordonnancement et de renommage des registres. Cela permet de mieux exploiter le parallélisme d’instructions et de garder les unités d’exécution constamment alimentées.

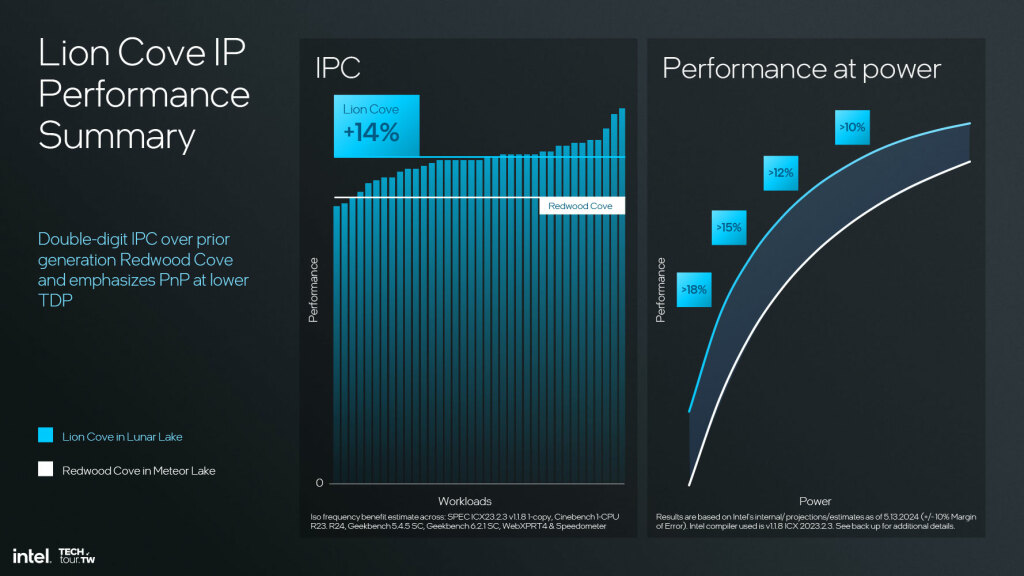

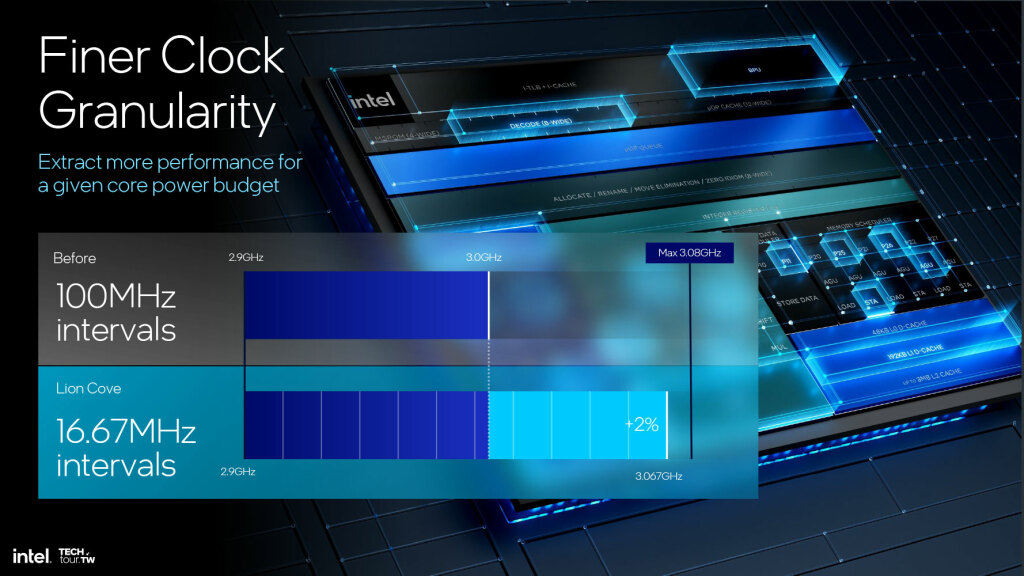

Le résultat de toutes ces améliorations est un bond générationnel en termes de performance. Intel annonce ainsi un gain d’IPC (instructions par cycle) de 14% en moyenne par rapport à Raptor Cove, avec des pointes à +18% sur les charges de travail les plus favorables. Le tout pour une consommation réduite grâce au contrôle granulaire de la fréquence et de la tension. Sur les charges variables, Lion Cove est ainsi capable de diviser sa consommation par deux à iso-performance.

Difficile à ce stade de comparer Lion Cove à ses concurrents directs, notamment les cœurs Oryon de Qualcomm et Avalanche d’ARM. Intel n’a pas communiqué les fréquences exactes de ses cœurs sur les différents segments de TDP. Mais au vu des chiffres annoncés, Lunar Lake s’annonce comme un sérieux prétendant à la couronne de l’efficacité énergétique. La réponse définitive viendra des benchmarks indépendants, qui ne manqueront pas à la sortie des premiers systèmes commerciaux.

Cœurs CPU efficients Skymont (E-Core)

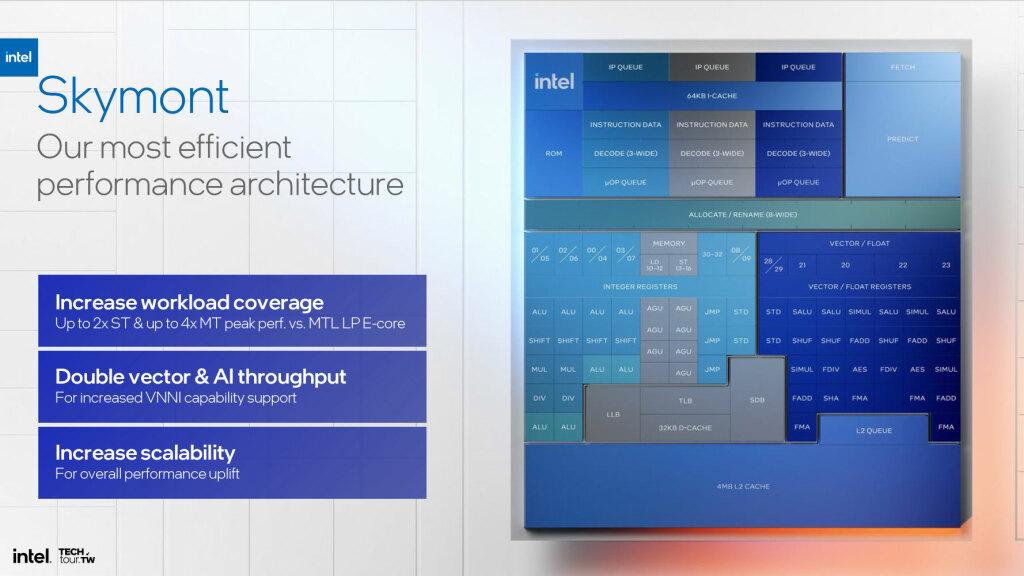

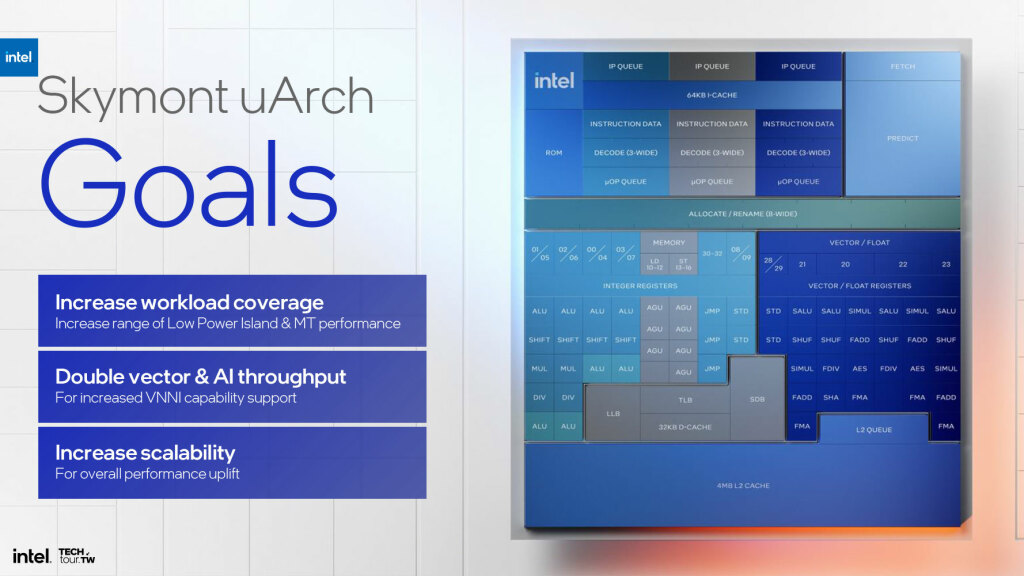

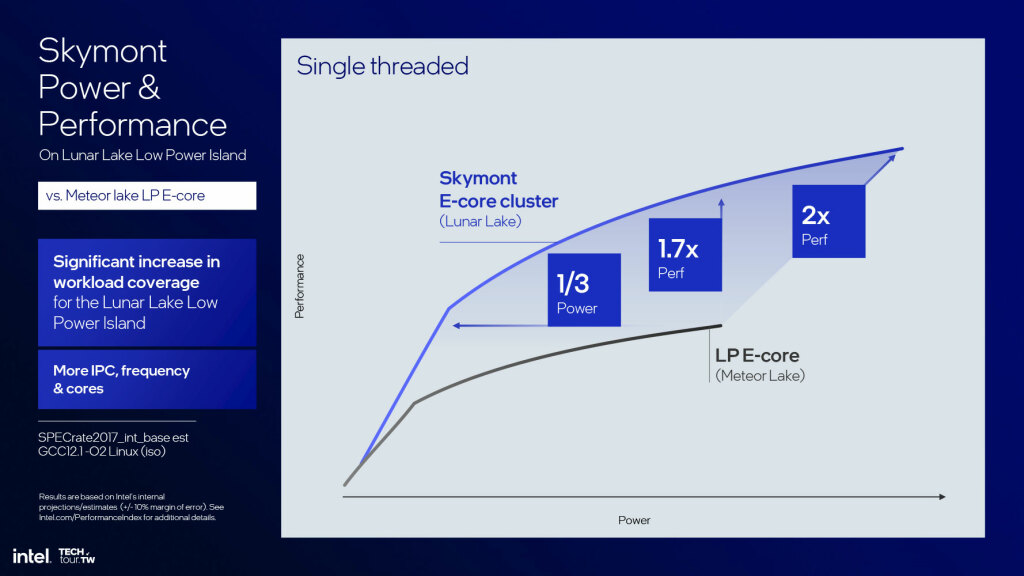

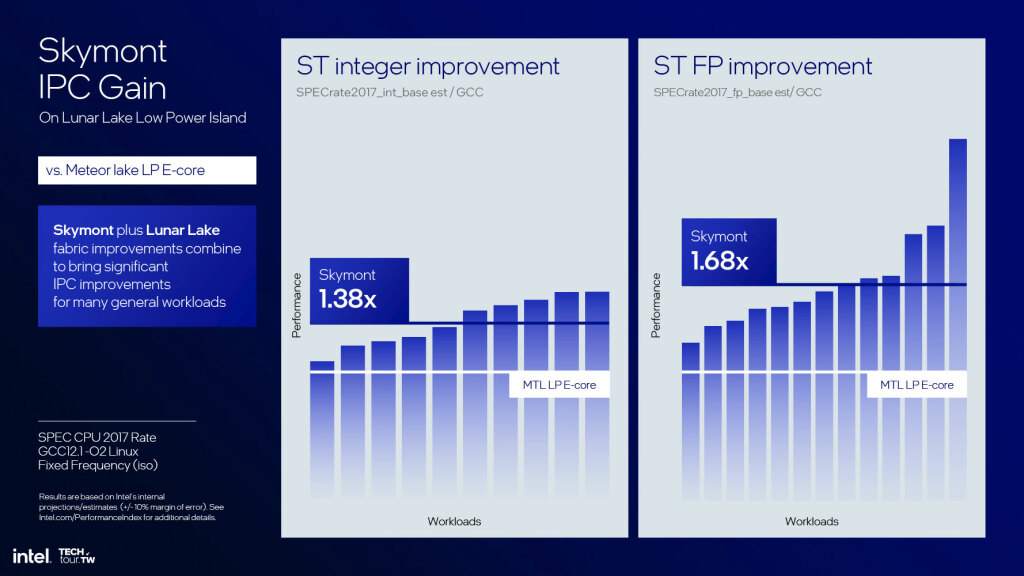

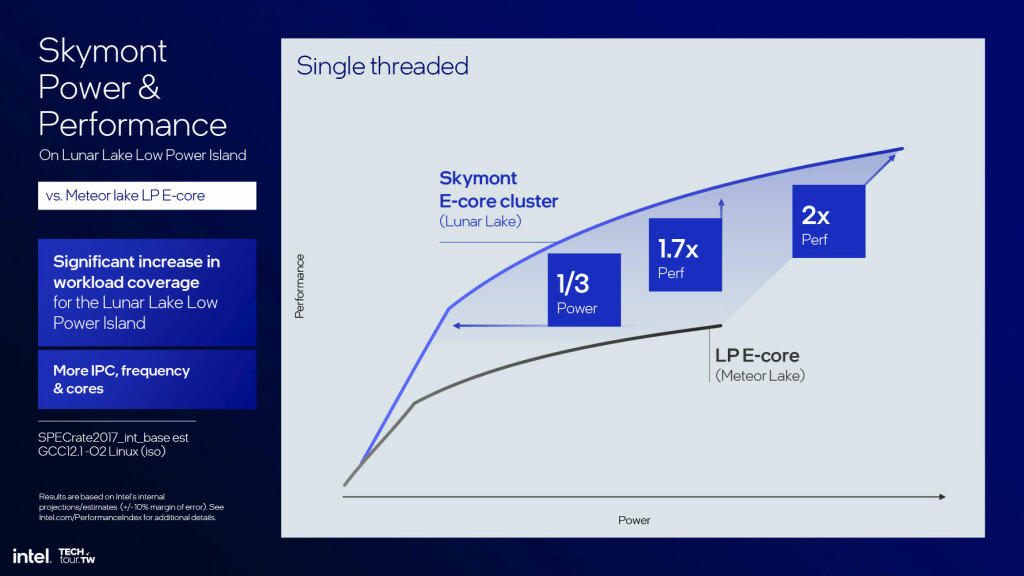

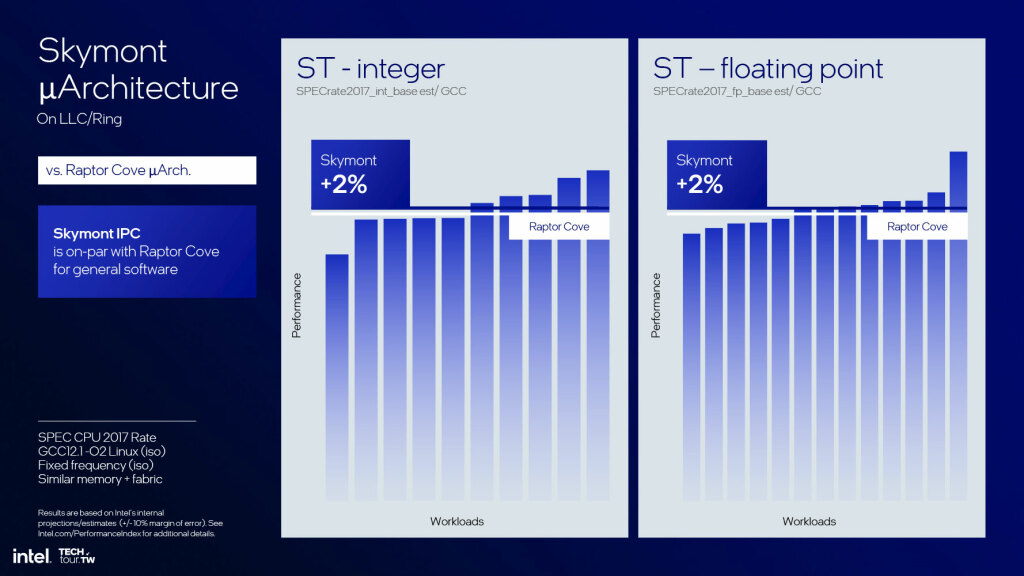

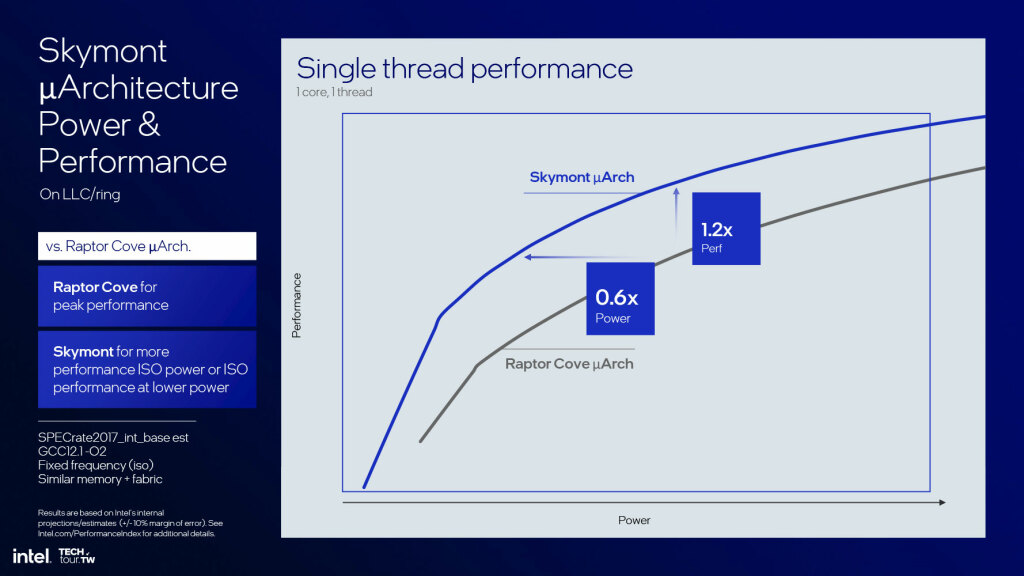

Si l’annonce des cœurs Lion Cove a fait grand bruit, c’est peut-être du côté des cœurs efficients que Lunar Lake impressionne le plus. Baptisés Skymont, ces petits soldats de l’efficacité sont en effet de véritables monstres de puissance malgré leur gabarit réduit. Pour preuve, Intel annonce fièrement qu’un cœur Skymont atteint désormais le même IPC que les cœurs Raptor Cove de la génération précédente, tout en consommant 3 fois moins d’énergie !

Pour atteindre un tel niveau de performance, les ingénieurs d’Intel ont dû repenser l’architecture des cœurs efficients de fond en comble. Partant du constat que la cible prioritaire pour ces cœurs est le calcul entier, ils ont misé sur un pipeline court (10 étages) mais très large, capable d’exécuter jusqu’à 8 instructions par cycle.

Pour alimenter ce monstre, le front-end a été considérablement étoffé. On trouve ainsi 3 décodeurs d’instructions, chacun capable de traiter un « cluster » de 3 instructions simultanément. La prédiction de branchements est également revue à la hausse, avec une granularité descendant jusqu’à 16 octets et une latence réduite grâce à l’implémentation d’un « buffer de discontinuité ».

Au niveau du cache de niveau L0, Skymont dispose de 64 Ko dédiés aux instructions, et de 32 Ko pour les données. Le cache L1 est quant à lui partagé entre les deux, avec une capacité de 128 Ko et une bande passante de 128 octets par cycle (2 lectures et 1 écriture). Pour les cas où les données ne seraient pas présentes dans ce cache, une requête est envoyée directement au L2, qui sert 256 Ko à 3 cycles de latence.

Mais la vraie nouveauté est l’apparition d’un « cache système » de 8 Mo, partagé par l’ensemble du SoC. Celui-ci fait office de cache de niveau L3, et permet de réduire drastiquement les accès à la DRAM. Un luxe que seuls les cœurs hautes performances pouvaient se permettre jusqu’à présent.

Afin de ne pas créer de goulot d’étranglement, le cache système est relié à la mémoire principale par un bus de 256 bits, cadencé à la fréquence de la DRAM. Cela permet d’atteindre une bande passante théorique de 68 Go/s, équivalente à celle des cœurs Lion Cove.

Mieux encore, ce cache est « non inclusif », ce qui signifie qu’il ne contient que des données qui ne sont pas déjà présentes dans les caches de niveau inférieur. Une approche qui permet d’optimiser l’utilisation de la capacité totale, et d’éviter les duplications inutiles.

Au niveau de l’exécution, Skymont mise sur un découplage encore plus poussé que Lion Cove entre les parties entière et flottante. On trouve ainsi 8 ALU entières pour seulement 2 unités 128-bits de type FMA (Fused Multiply-Add) pour les calculs en virgule flottante. Un ratio qui peut sembler déséquilibré, mais qui colle parfaitement aux charges de travail visées, très majoritairement entières.

Pour autant, Skymont n’oublie pas totalement le parallélisme d’instructions. Ainsi, chaque unité 128-bits peut être utilisée indépendamment pour exécuter 2 instructions SSE (Streaming SIMD Extensions) par cycle, pour un total de 16 opérations flottantes (8 additions et 8 multiplications) par cycle. De quoi assurer un minimum de performance sur les applications multimédia ou les jeux vidéo peu gourmands.

L’autre grande nouveauté est le support des instructions AVX2, une première sur un cœur efficient x86. Celles-ci permettent de traiter des vecteurs de 256 bits, soit le double de la largeur des registres physiques. Pour ce faire, Skymont utilise deux unités 128-bits en parallèle, avec un mécanisme de « fusion » des résultats. Une prouesse rendue possible par la présence de 4 ports de lecture 128-bits sur le fichier de registres.

Mieux encore, Skymont supporte également les instructions AVX-VNNI (Vector Neural Network Instructions), qui permettent d’accélérer les calculs d’inférence des réseaux de neurones. Une fonctionnalité héritée des processeurs Xeon d’Intel, et qui promet des gains significatifs sur les charges de travail d’intelligence artificielle.

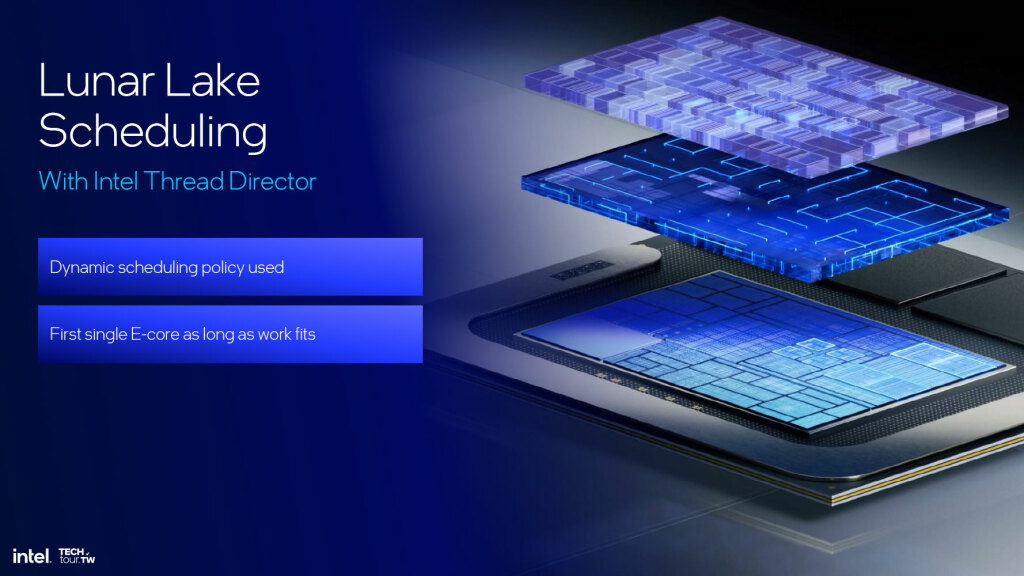

Pour orchestrer tout ce petit monde, Intel a développé un nouveau contrôleur de threads matériel baptisé « Thread Director 3.0 ». Celui-ci est capable d’analyser en temps réel le comportement des tâches en cours d’exécution, et de les assigner dynamiquement aux cœurs les plus adaptés. Par défaut, toutes les nouvelles tâches sont envoyées sur les cœurs Skymont, et ne sont basculées sur les cœurs Lion Cove que si le Thread Director détecte un besoin important de performance single-thread.

Cette approche permet de maximiser l’efficacité énergétique globale du SoC, en n’activant les cœurs haute performance que lorsque cela est vraiment nécessaire. Le Thread Director prend également en compte des paramètres tels que la température du die ou l’état de charge de la batterie pour ajuster sa politique d’ordonnancement en fonction du contexte.

Au final, Skymont représente un saut générationnel majeur pour les cœurs efficients x86. Avec un IPC équivalent à celui des meilleurs cœurs mobiles actuels, mais pour une fraction de leur consommation, ils ouvrent la voie à de nouveaux usages pour les PC ultra-portables. On peut ainsi imaginer des machines capables de tenir une journée entière en utilisation bureautique, tout en offrant des performances de premier ordre pour les tâches ponctuelles plus exigeantes.

Une polyvalence qui pourrait bien rebattre les cartes sur le marché des ultrabooks haut de gamme, traditionnellement dominé par Apple et ses puces ARM. Réponse dans quelques mois, avec les premiers benchmarks indépendants des systèmes commerciaux.

GPU intégré nouvelle génération Xe2 Battlemage

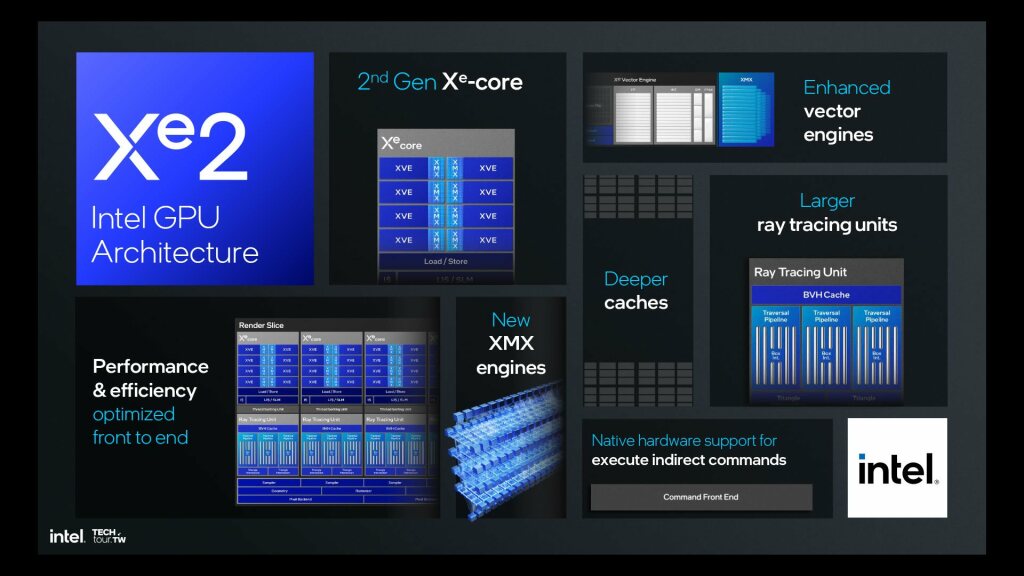

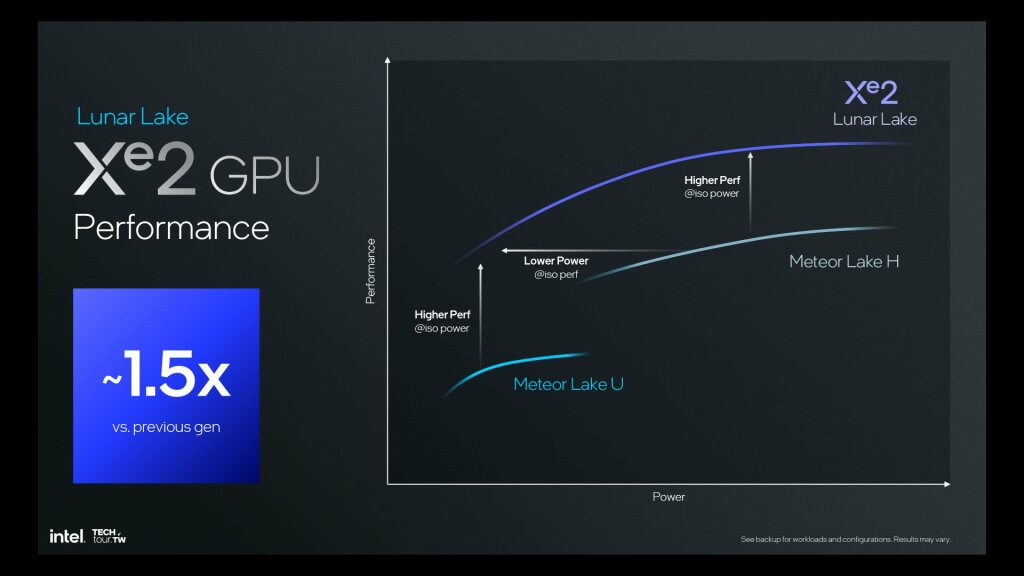

L’autre grande nouveauté de Lunar Lake est son GPU intégré, qui fait le grand saut vers l’architecture Xe2 Battlemage. Dérivée des cartes graphiques discrètes Arc d’Intel, celle-ci promet un bond générationnel en termes de performances et de fonctionnalités. De quoi enfin rattraper le retard accumulé sur AMD et ses GPU Vega, voire surpasser les solutions intégrées de NVIDIA.

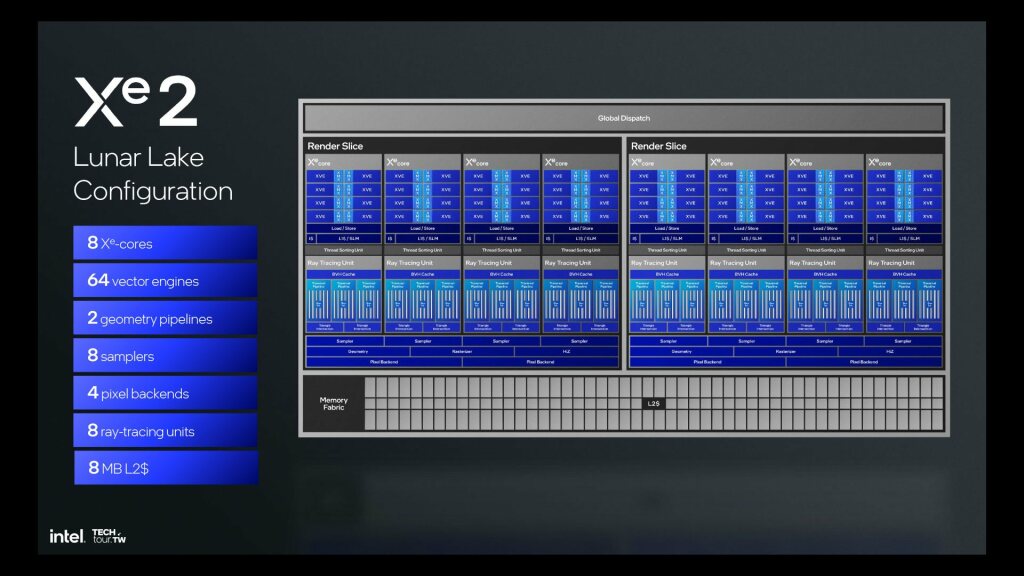

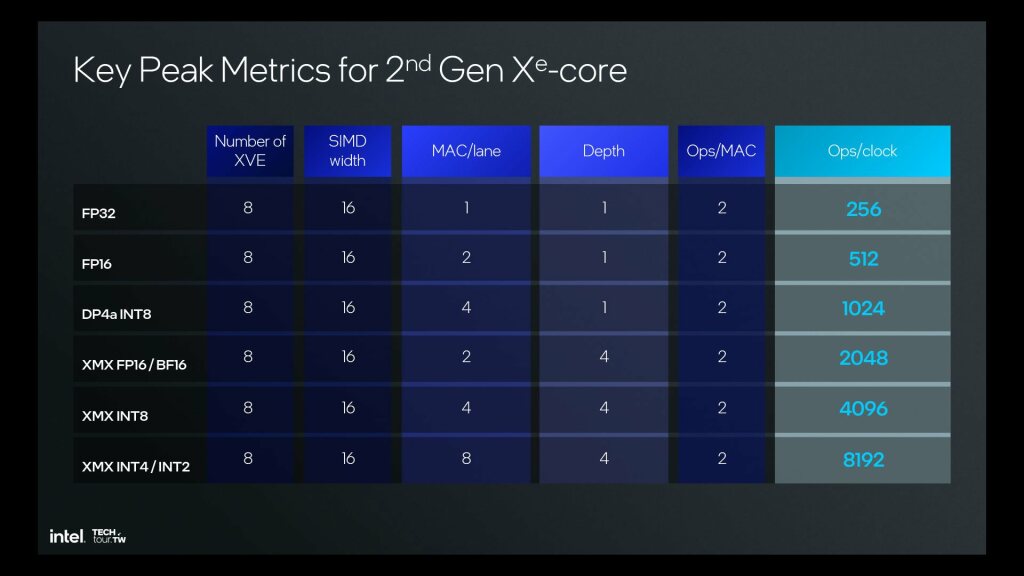

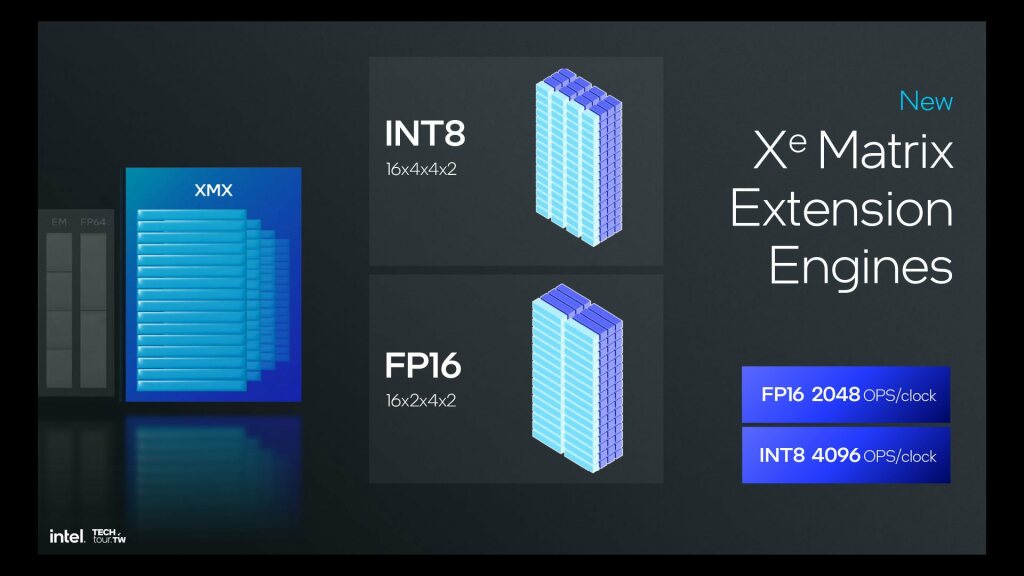

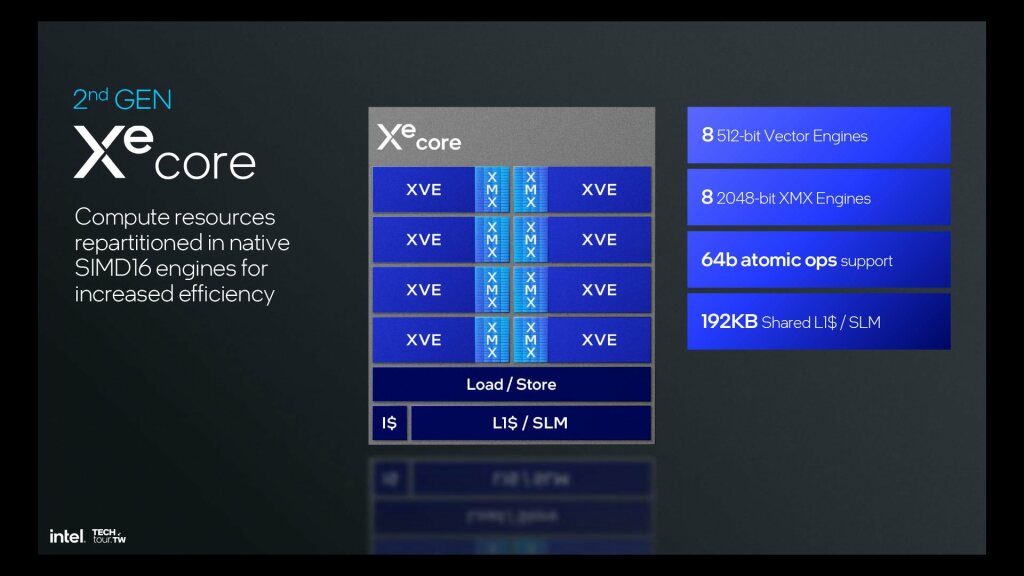

Pour ce faire, Intel a fortement étoffé les unités d’exécution de ses GPU. On trouve ainsi 8 cœurs Xe, chacun composé de 8 unités vectorielles 512-bits (XVE) et de 8 unités matricielles 2048-bits (XMX). Soit un total de 1024 « shading units » en jargon GPU, ou 4096 ALU FP32 en langage clair.

A cela s’ajoutent 4 unités de texturing et 4 ROP (Render Output Units) par cœur, ainsi qu’un cache de niveau L2 partagé de 8 Mo. Le tout est interconnecté par un fabric en anneau, qui permet d’atteindre une bande passante mémoire de 196 Go/s en exploitant pleinement les 4 canaux LPDDR5X-8500 du SoC.

Mais la vraie nouveauté est l’intégration native du ray tracing, une première sur un GPU basse consommation. Chaque cœur Xe dispose ainsi d’une unité de BVH (Bounding Volume Hierarchy) dédiée, capable de calculer les intersections des rayons lumineux avec les polygones de la scène. De quoi accélérer significativement les effets d’ombrage, de réflexion et de réfraction propres à cette technique.

Pour gérer tout ce flot de données, Xe2 dispose d’un pipeline géométrique entièrement refondu. Celui-ci est désormais capable de traiter jusqu’à 4 triangles par cycle, soit 2 fois plus que la génération précédente. Le tri et l’assemblage des vertices sont également accélérés, avec une bande passante doublée et une latence réduite de moitié.

Au niveau des performances brutes, Intel annonce des gains significatifs par rapport à Meteor Lake. Sur les benchmarks internes de la firme, Lunar Lake serait ainsi 50% plus véloce en moyenne, avec des pointes à +80% sur les jeux les plus gourmands. Des chiffres qu’il faudra bien sûr prendre avec des pincettes, en attendant les tests indépendants.

Mais au-delà des performances pures, c’est surtout sur le terrain des fonctionnalités qu’Intel entend faire la différence. Outre le ray tracing, Xe2 supporte nativement les dernières API graphiques, telles que DirectX 12 Ultimate, Vulkan 1.3 ou encore OpenCL 3.0. De quoi garantir une compatibilité optimale avec les jeux et applications les plus récents.

Le GPU intègre également un moteur d’accélération dédié à l’intelligence artificielle, baptisé XMX (Xe Matrix Extensions). Celui-ci est capable de réaliser jusqu’à 48 TOPS (billions d’opérations par seconde) en précision INT8, soit 2 fois plus que le NPU dédié du SoC. De quoi accélérer efficacement les tâches d’inférence, telles que la reconnaissance d’image ou le traitement du langage naturel.

Autre nouveauté, le support natif du format FP16, qui permet de doubler les performances en réduisant la précision des calculs flottants. Une fonctionnalité particulièrement utile pour les applications de deep learning, qui utilisent massivement ce type de données.

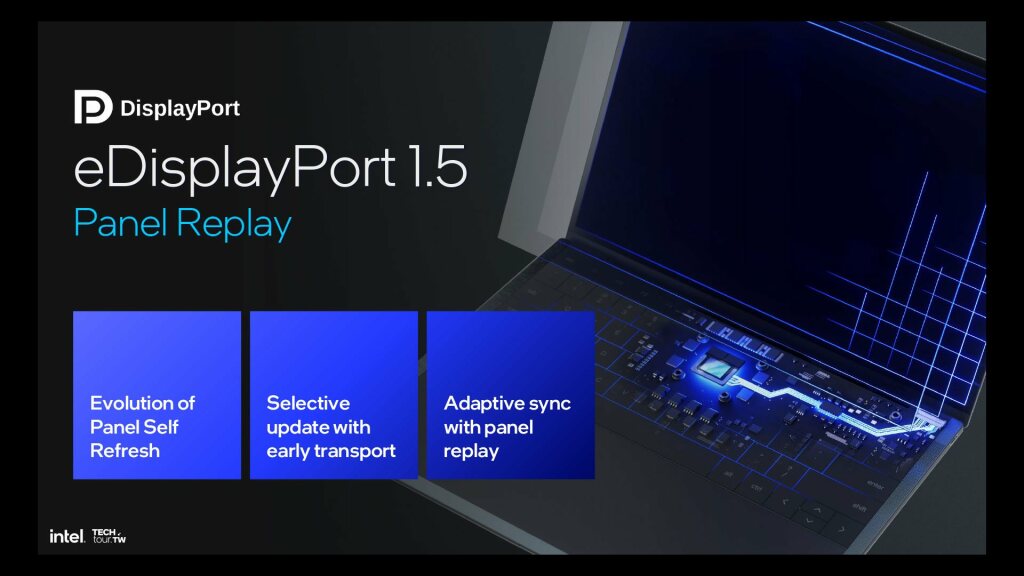

Enfin, Xe2 intègre un contrôleur d’affichage entièrement refondu, capable de piloter jusqu’à 4 écrans 4K HDR à 120 Hz, ou 2 écrans 8K HDR à 60 Hz. Le tout avec une profondeur de couleur de 12 bits par canal, et une couverture de 100% des espaces DCI-P3 et Rec2020.

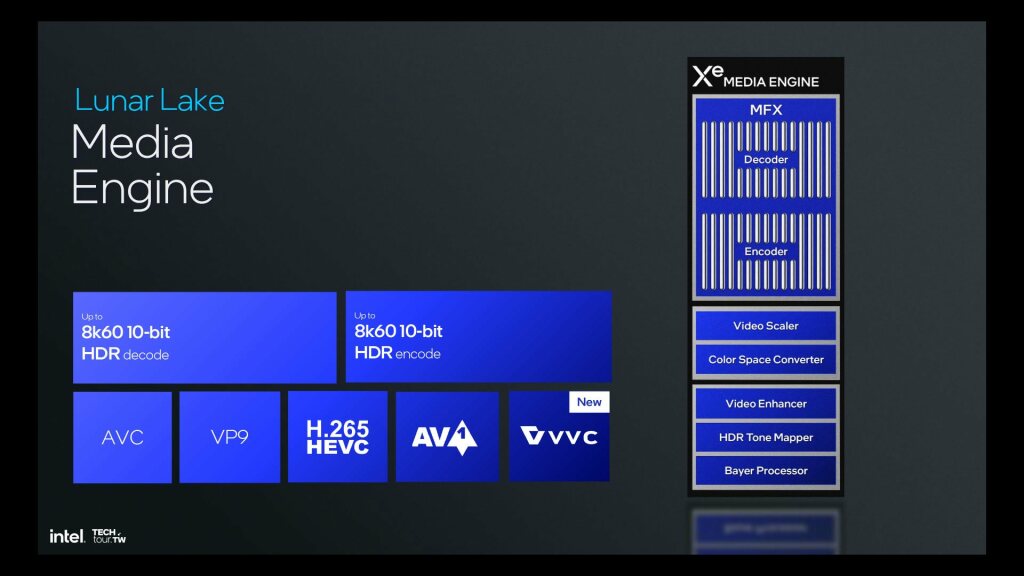

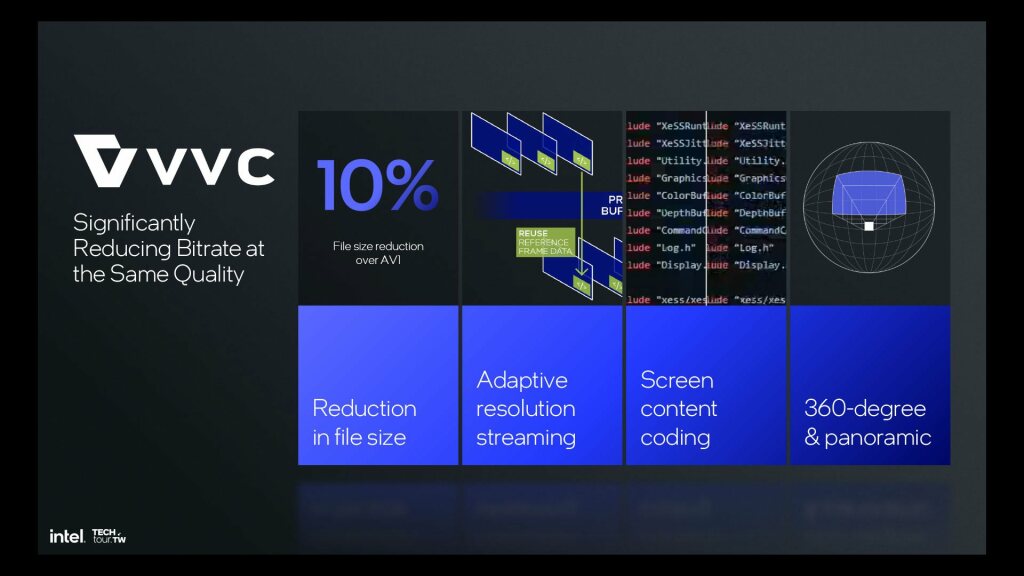

Pour la partie vidéo, le GPU supporte le décodage matériel des codecs AV1, HEVC et VP9, avec une résolution maximale de 8K à 60 images par seconde. L’encodage est également de la partie, avec la prise en charge des codecs HEVC et AV1, jusqu’en 8K à 30 images par seconde.

Au final, Xe2 représente un véritable bond en avant pour les GPU intégrés d’Intel. Avec des performances en hausse de 50% et des fonctionnalités dignes d’une carte graphique d’entrée de gamme, il promet une expérience de jeu et de création nettement plus fluide sur les ultraportables. Reste à voir comment il se comportera face aux Radeon 780M d’AMD et aux GeForce MX570 de NVIDIA, ses principaux concurrents sur ce segment.

Neural Processing Unit 4e génération

S’il est un domaine où Intel compte bien creuser l’écart avec la concurrence, c’est celui de l’intelligence artificielle. Et pour cause, la firme de Santa Clara dispose d’une arme de choix avec son NPU maison, fruit du rachat de la startup israélienne Habana Labs en 2019.

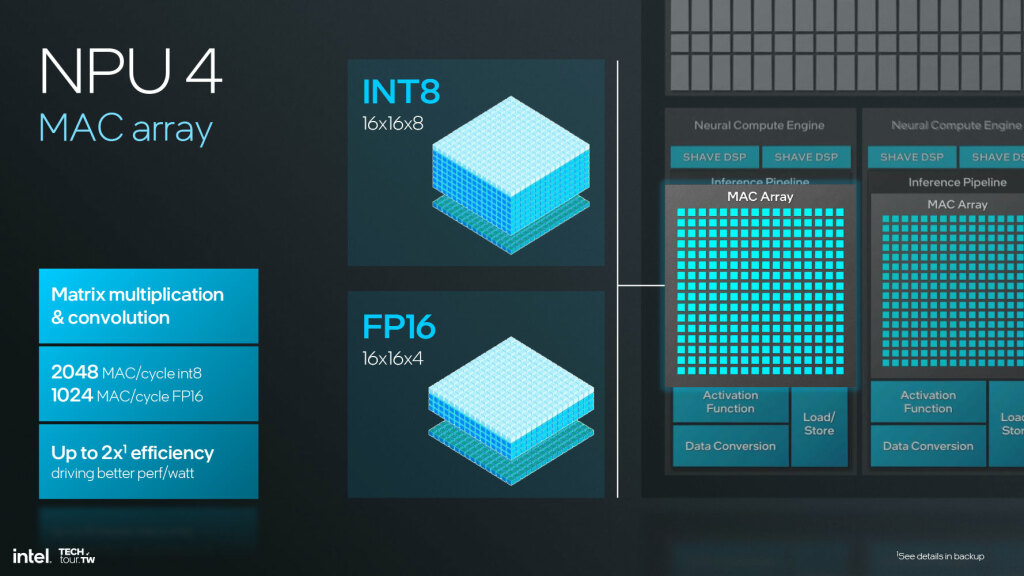

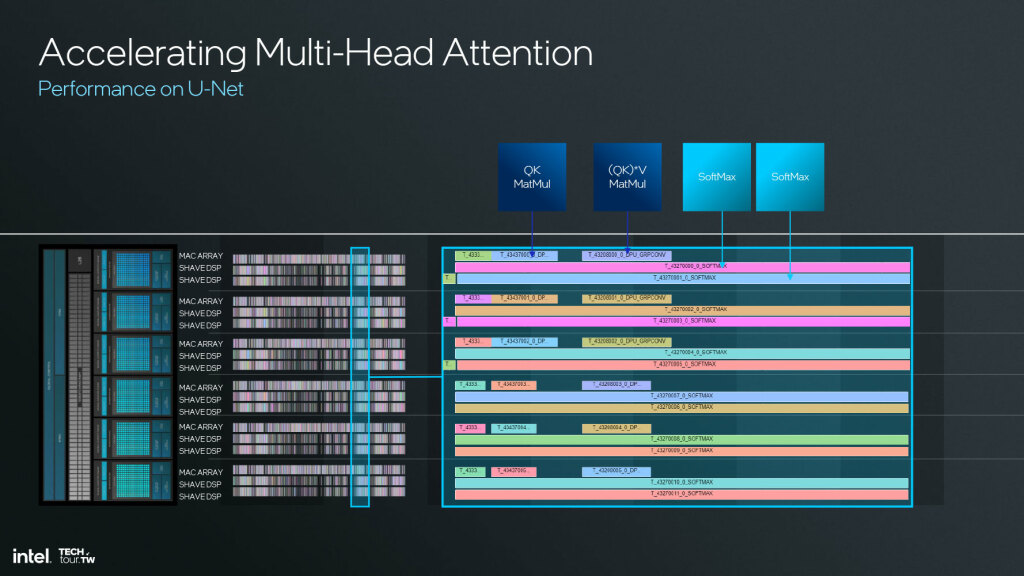

Pour Lunar Lake, Intel intègre ainsi la 4e génération de son NPU, baptisée NNP-I 1000. Celle-ci se présente comme une unité de calcul entièrement dédiée à l’accélération des réseaux de neurones, avec une architecture optimisée pour les faibles consommations.

Au cœur de ce NPU, on trouve 6 « Neural Compute Engines » (NCE), chacun composé de 12 cœurs TNP (TensorFlow Neural Processor). Ceux-ci sont capables de réaliser des opérations matricielles de grande taille, avec une précision allant de l’INT4 au FP16. Le tout à une fréquence de 1,95 GHz, soit 40% de plus que la génération précédente.

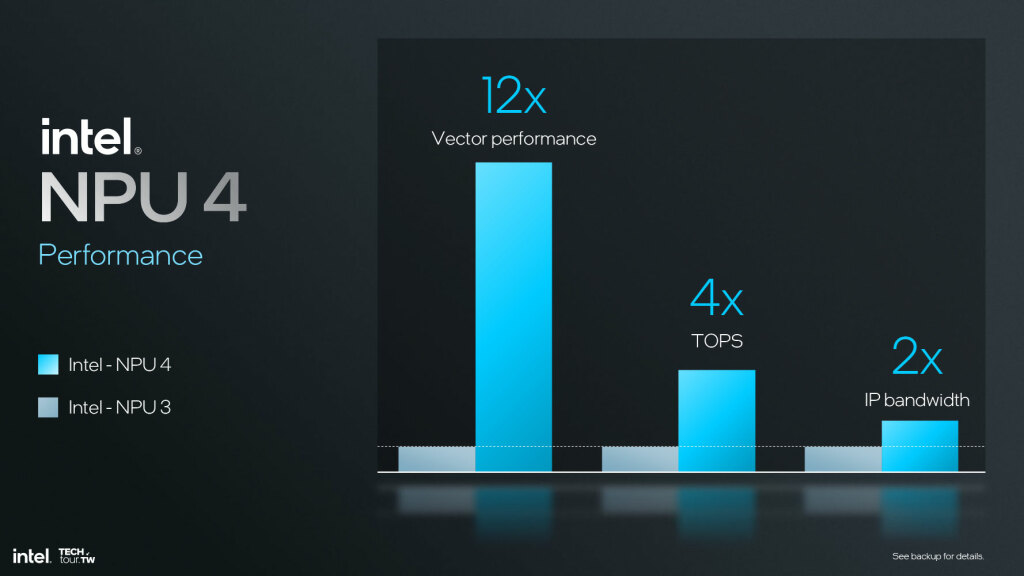

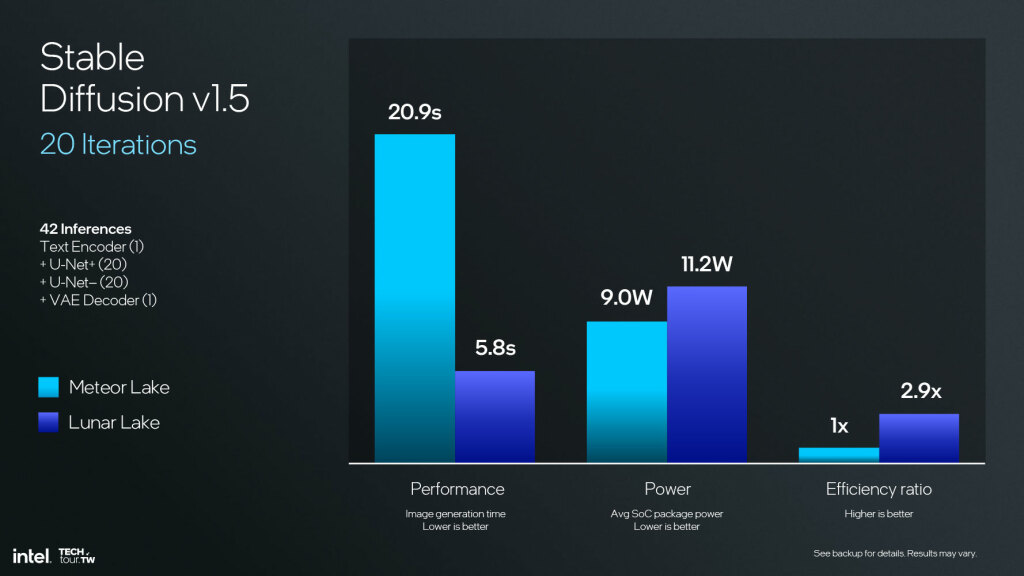

En termes de performances brutes, NNP-I 1000 atteint ainsi 48 TOPS en précision INT8, contre 11 TOPS pour le NPU de Meteor Lake. Soit un bond de plus de 4X, qui permet à Intel de prendre la tête du peloton sur ce critère. A titre de comparaison, le NPU du Snapdragon 8cx Gen 3 de Qualcomm culmine à 29 TOPS, tandis que celui de l’Apple M2 se contente de 15,8 TOPS.

Mais au-delà des chiffres, c’est surtout l’efficacité énergétique qui impressionne. Grâce à une conception basse consommation et à une gravure en 3 nm, NNP-I 1000 atteint 2,5 TOPS/W en INT8, soit 2 fois plus que son prédécesseur. De quoi exécuter les modèles de deep learning les plus gourmands, sans pour autant vider la batterie en un rien de temps.

Pour alimenter ce monstre de calcul, Intel a doté son NPU d’une bande passante mémoire de 400 Go/s, grâce à 4 contrôleurs LPDDR5X-8500 dédiés. Le tout est complété par 16 Mo de SRAM distribuée au sein des NCE, ainsi que 8 Mo de cache L2 partagé. De quoi éviter les goulets d’étranglement, même sur les modèles les plus imposants.

Au niveau logiciel, NNP-I 1000 est compatible avec les principaux frameworks d’intelligence artificielle du marché, tels que TensorFlow, PyTorch ou encore ONNX. Il supporte également les API DirectML de Microsoft et SYCL de Khronos, qui permettent d’exploiter le NPU de manière unifiée, quel que soit le type de charge de travail.

Côté applicatif, Intel voit son NPU comme un accélérateur polyvalent, capable de prendre en charge la plupart des tâches d’IA du quotidien. On pense notamment à la reconnaissance faciale pour l’authentification Windows Hello, à la cancellation de bruit pour les visioconférences, ou encore à la colorisation automatique des photos.

Mais c’est surtout sur le terrain de l’IA générative qu’Intel entend faire la différence. Grâce à la puissance de son NPU, Lunar Lake sera ainsi capable d’exécuter localement des modèles de langage tels que GPT-3 ou BERT, sans avoir à passer par le cloud. Une avancée majeure, qui ouvre la voie à de nouveaux cas d’usage pour l’IA conversationnelle, tels que les assistants virtuels personnalisés ou les agents de support client autonomes.

Autre domaine d’application prometteur, la réalité augmentée et virtuelle. Grâce à sa faible consommation et à sa compatibilité avec les casques de VR standalone, NNP-I 1000 pourra ainsi prendre en charge des tâches telles que le suivi du regard, la reconnaissance de gestes ou encore la génération de hologrammes en temps réel.

Enfin, le NPU de Lunar Lake sera un atout de choix pour le développement des voitures autonomes. En effet, sa capacité à exécuter des modèles de perception visuelle et de prise de décision en temps réel, tout en consommant un minimum d’énergie, en fait un accélérateur idéal pour les systèmes d’aide à la conduite (ADAS).

Au final, NNP-I 1000 représente une avancée majeure pour l’IA embarquée sur PC. Avec des performances en hausse de 4X et une efficacité énergétique doublée, il promet de démocratiser l’usage des réseaux de neurones les plus avancés, sans compromis sur l’autonomie ou la réactivité du système. Une approche qui pourrait bien rebattre les cartes face aux solutions concurrentes de Qualcomm, Apple ou encore NVIDIA.

Mémoire système et cache intégré

Outre ses cœurs CPU et GPU nouvelle génération, Lunar Lake innove également sur le plan de la mémoire système. Pour la première fois sur une plateforme x86, le SoC intègre en effet la totalité de la DRAM sur son package, une approche jusqu’ici réservée aux puces ARM d’Apple et Qualcomm.

Concrètement, Lunar Lake embarque 4 puces LPDDR5X-8500 de 16 Gbit chacune, pour une capacité totale allant jusqu’à 32 Go. Celles-ci sont reliées au SoC par un bus mémoire de 128 bits, cadencé à 4266 MHz pour une bande passante de 68 Go/s.

Mais l’innovation ne s’arrête pas là. En effet, pour réduire la consommation et la latence d’accès à la DRAM, Intel a développé une nouvelle technologie de cache de niveau L4, baptisée Memory Side Cache (MSC). Celle-ci se présente comme une SRAM de 8 Mo, gravée directement sur l’interposer du package et reliée au bus mémoire par des TSV (Through Silicon Vias).

L’idée est d’utiliser ce cache pour stocker les données les plus fréquemment accédées par les différents blocs du SoC (CPU, GPU, NPU, ISP, etc.), afin d’éviter les allers-retours coûteux vers la DRAM. Pour ce faire, le MSC est divisé en plusieurs partitions, chacune dédiée à un type de trafic spécifique (instructions, données, textures, etc.). Le contrôleur de cache se charge ensuite d’optimiser le placement des données en fonction des patterns d’accès observés, afin de maximiser le taux de hit.

Selon Intel, cette approche permet de réduire la consommation liée aux accès DRAM de 20% en moyenne, tout en améliorant la bande passante effective de 50%. Des gains significatifs, qui se traduisent par une autonomie en hausse et des performances plus stables, notamment dans les scénarios de forte charge.

Mais le MSC n’est pas qu’un simple cache de niveau supérieur. En effet, il sert également de point de cohérence pour l’ensemble des caches du SoC, en gardant une copie à jour des données partagées entre les différents blocs. Une approche qui permet d’éviter les conflits et les incohérences, tout en réduisant le trafic sur le bus mémoire.

Enfin, le MSC joue un rôle clé dans la gestion de l’énergie du SoC. Grâce à sa grande capacité et à sa faible latence, il permet en effet de maintenir les données actives pendant les phases de veille profonde (deep sleep), sans avoir à les rafraîchir depuis la DRAM. Une fonctionnalité particulièrement utile pour les scénarios d’always-on, tels que la surveillance des notifications ou la détection des mots clés.

Au final, le Memory Side Cache apparaît comme l’une des innovations les plus prometteuses de Lunar Lake. En combinant les avantages d’un cache de grande capacité avec ceux d’une mémoire système intégrée, il ouvre la voie à de nouveaux horizons en termes de performances et d’efficacité énergétique. Une approche qui pourrait bien faire des émules chez les concurrents d’Intel, à commencer par AMD et ses futures puces Ryzen 8000.

Connectivité et I/O avec le Platform Controller Tile

Dernière brique du puzzle Lunar Lake, le Platform Controller Tile (PCT) regroupe l’ensemble des interfaces d’entrées-sorties et des contrôleurs de périphériques du SoC. Une approche modulaire, qui permet à Intel de découpler le développement du PCT de celui des autres tuiles, afin d’accélérer la mise sur le marché de ses nouvelles plateformes.

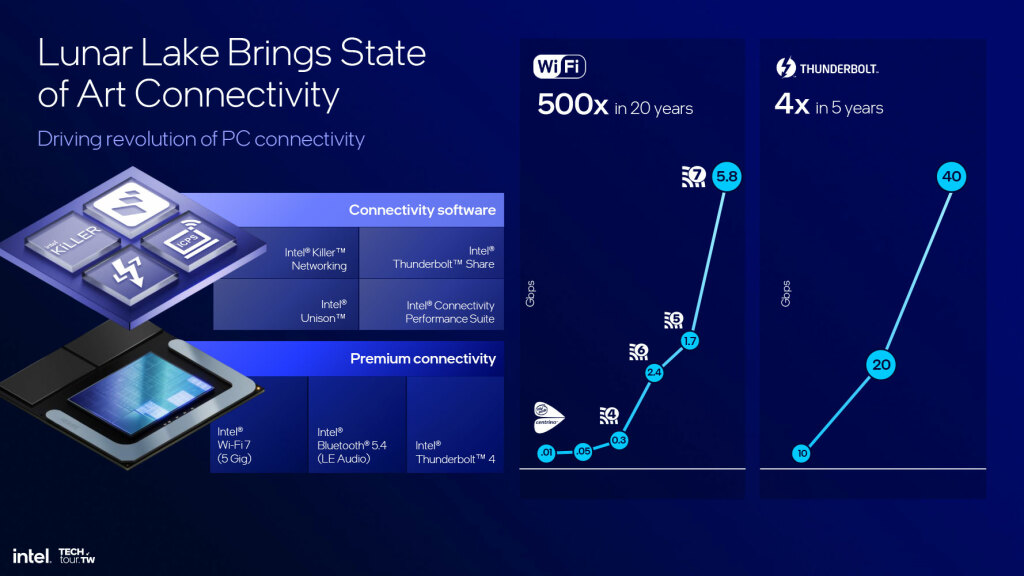

Gravé en 6 nm chez TSMC, le PCT de Lunar Lake se distingue par son haut niveau d’intégration. On y trouve ainsi un contrôleur PCIe 5.0 16 lignes, un contrôleur Thunderbolt 4 40 Gbps, un contrôleur USB4 40 Gbps, ainsi qu’un contrôleur Ethernet 10 GbE. Le tout complété par un hub USB 3.2 20 Gbps et un contrôleur audio HD.

Mais la grande nouveauté est l’intégration native du Wi-Fi 7, une première sur une plateforme mobile x86. Grâce à sa puce CNVi (Connectivity Integration) maison, Intel promet ainsi des débits allant jusqu’à 5,8 Gbps, soit 2 fois plus que le Wi-Fi 6E actuellement disponible. De quoi garantir une expérience de streaming et de jeu en cloud optimale, même dans les environnements sans-fil les plus denses.

Pour ce faire, le Wi-Fi 7 s’appuie sur plusieurs technologies de pointe, telles que le beamforming, le MU-MIMO et l’OFDMA. Il bénéficie également d’une bande passante élargie à 320 MHz, ainsi que d’une modulation 4096-QAM pour des débits accrus. Enfin, il tire parti de l’agrégation de porteuses et du multi-link operation pour agréger jusqu’à 4 canaux non contigus, afin de s’adapter dynamiquement aux interférences et aux congestions du réseau.

Outre le Wi-Fi 7, le PCT de Lunar Lake intègre également un contrôleur Bluetooth 5.3, qui apporte son lot d’améliorations en termes de débit, de portée et de latence. On note ainsi l’ajout du LE Audio, qui permet de diffuser un son haute qualité vers plusieurs périphériques BT simultanément, ainsi que le support du Bluetooth LE Multi-Stream pour des connexions plus stables et réactives.

Au rayon des interfaces filaires, Lunar Lake se distingue par son support natif de l’USB4 version 2.0, qui double la bande passante par rapport à l’USB4 1.0 actuel (de 40 à 80 Gbps). Une évolution rendue possible par l’utilisation de câbles 80 Gbps Active et d’un nouveau protocole de signalisation, qui permet de transporter jusqu’à 120 Gbps sur une seule paire différentielle.

Enfin, le PCT de Lunar Lake intègre une nouvelle génération de Thunderbolt, baptisée Thunderbolt 5. Celle-ci conserve la compatibilité avec l’USB4 80 Gbps, tout en apportant des fonctionnalités supplémentaires telles que le support du DisplayPort 2.1 UHBR 20 et le Thunderbolt Alternate Mode pour les connexions PCIe et SAS.

Côté sécurité, le PCT embarque une nouvelle mouture du contrôleur de sécurité Platform Trust Technology (PTT), qui sert de base de confiance matérielle pour l’ensemble du SoC. Celui-ci intègre désormais un accélérateur AES-256-GCM dédié, ainsi qu’un générateur de nombres aléatoires True RNG 800-90B pour une entropie accrue.

Au final, le Platform Controller Tile apparaît comme l’un des atouts majeurs de Lunar Lake. En intégrant nativement les standards de connectivité et d’I/O les plus avancés, il permet à Intel de proposer une plateforme résolument tournée vers l’avenir, sans compromis sur la compatibilité ou la sécurité. Une approche qui devrait séduire les OEM, toujours en quête de différenciation et de simplicité de conception.

Gestion intelligente des tâches avec le Thread Director

Pour tirer le meilleur parti de son architecture hybride, Lunar Lake s’appuie sur une nouvelle génération de Thread Director, le contrôleur matériel chargé de distribuer les tâches entre les différents cœurs du SoC. Une mission cruciale, qui nécessite à la fois une connaissance fine des caractéristiques de chaque thread et une vision globale de l’état du système.

Pour ce faire, le Thread Director de Lunar Lake s’appuie sur un nouveau jeu de compteurs de performance matériels, qui lui permettent de caractériser en temps réel le comportement de chaque tâche. Parmi les métriques collectées, on trouve ainsi le nombre d’instructions par cycle (IPC), le taux de branchements, le taux de défauts de cache ou encore la densité arithmétique.

Grâce à ces informations, le Thread Director est capable de classer les tâches en 4 catégories distinctes :

- Les tâches légères (Type 0), qui présentent un IPC similaire sur les cœurs P et E et peuvent donc être exécutées indifféremment sur les deux types de cœurs.

- Les tâches intensives en calcul vectoriel (Type 1), qui tirent parti des unités d’exécution plus larges des cœurs P et sont donc prioritairement affectées à ces derniers.

- Les tâches orientées Machine Learning (Type 2), qui exploitent les instructions AVX-VNNI des cœurs E et sont donc dirigées vers ces cœurs lorsque cela est possible.

- Les tâches peu scalables (Type 3), qui ne bénéficient pas d’une accélération significative quel que soit le type de cœur et sont donc affectées aux cœurs E par défaut pour économiser l’énergie.

Une fois cette classification effectuée, le Thread Director communique ses recommandations au scheduler de l’OS sous forme d’hints, en indiquant pour chaque tâche le type de cœur le plus adapté et le gain de performance attendu. Charge ensuite au scheduler de prendre la décision finale d’ordonnancement, en fonction des contraintes globales du système (charge, température, priorité, etc.).

Pour affiner encore le placement des tâches, Lunar Lake introduit également la notion de zone de confinement. L’idée est de permettre à l’OS de définir des zones logiques au sein du SoC, chacune correspondant à un type de cœur donné (P, E ou hybride). Les tâches critiques peuvent ainsi être confinées dans la zone P pour garantir un haut niveau de performance, tandis que les tâches de fond seront cantonnées à la zone E pour minimiser leur impact sur l’autonomie.

Enfin, le Thread Director de Lunar Lake apporte son lot d’optimisations pour les cas d’usage spécifiques. On note ainsi l’ajout d’un mode « jeu », qui donne la priorité aux tâches du rendu graphique et de la physique sur les cœurs P, tout en maintenant les tâches de fond sur les cœurs E. Ou encore un mode « créatif », qui réserve les cœurs P aux tâches de compilation, d’encodage et de rendu, tout en basculant les tâches de prévisualisation sur les cœurs E.

Au final, le Thread Director s’impose comme la clé de voûte de l’architecture hybride de Lunar Lake. En offrant une granularité et une réactivité inédites dans le placement des tâches, il permet à Intel de tirer le meilleur parti de ses différents types de cœurs, sans jamais sacrifier la performance ou l’autonomie. Une avancée majeure, qui pourrait bien rebattre les cartes face aux architectures concurrentes d’ARM et d’AMD.

Avis PH

Au terme de cette analyse détaillée, une conclusion s’impose : avec Lunar Lake, Intel signe une petite révolution dans le monde des processeurs pour PC portables. En combinant une gravure en 3 nm dernière génération avec une conception hybride innovante et un niveau d’intégration inédit, le fondeur américain promet en effet un bond générationnel sur tous les fronts : performance, efficacité énergétique, fonctionnalités et connectivité.

Bien sûr, il faudra attendre les premiers tests indépendants pour confirmer les promesses d’Intel. Mais sur le papier, Lunar Lake a tout pour damer le pion à la concurrence. Avec des cœurs hautes performances 15% plus véloces que la génération précédente, des cœurs efficients capables d’égaler les anciens cœurs Raptor Cove, et un GPU deux fois plus rapide que celui de Meteor Lake, le nouveau SoC d’Intel semble taillé pour offrir une expérience premium, sans compromis sur l’autonomie.

Mieux encore, Lunar Lake se distingue par son niveau d’intégration inédit. En embarquant la mémoire DRAM directement sur son package, en misant sur un cache de niveau 4 pour réduire les accès coûteux à la RAM, et en intégrant nativement les derniers standards de connectivité et d’I/O, il ouvre la voie à de nouveaux facteurs de forme et de nouvelles expériences utilisateur.

Enfin, la nouvelle génération de Thread Director apparaît comme l’un des atouts maîtres d’Intel pour optimiser le placement des tâches sur ses différents types de cœurs. Grâce à une granularité et une réactivité accrues, elle promet en effet une gestion intelligente et dynamique des ressources du SoC, sans jamais sacrifier la performance ou l’autonomie.

Bien sûr, il reste encore de nombreuses zones d’ombre. Quid de la segmentation exacte de la gamme Lunar Lake, des fréquences atteintes par les différents blocs, ou encore de la consommation réelle en charge ? Autant de questions qui trouveront leur réponse dans les mois à venir, à l’approche de la commercialisation des premiers systèmes.

Mais une chose est sûre : avec Lunar Lake, Intel semble avoir retrouvé son mojo. Après des années de stagnation et de retard face à AMD et Apple, le géant de Santa Clara revient en force avec une plateforme résolument tournée vers l’avenir, qui coche toutes les cases du cahier des charges d’un PC portable moderne. De quoi redistribuer les cartes sur un marché ultra-concurrentiel, où l’innovation et l’intégration sont plus que jamais les clés du succès.