Giga Computing, filiale de Gigabyte, lance le serveur AI XN24-VC0-LA61 en watercooling direct, bâti sur la plateforme Nvidia GB200 NVL4. Format 2U, double processeur, architecture hétérogène CPU + GPU, il vise les nœuds cœur d’infrastructures AI à haute densité sans imposer un déploiement rack complet.

Architecture Grace + Blackwell, refroidie en DLC

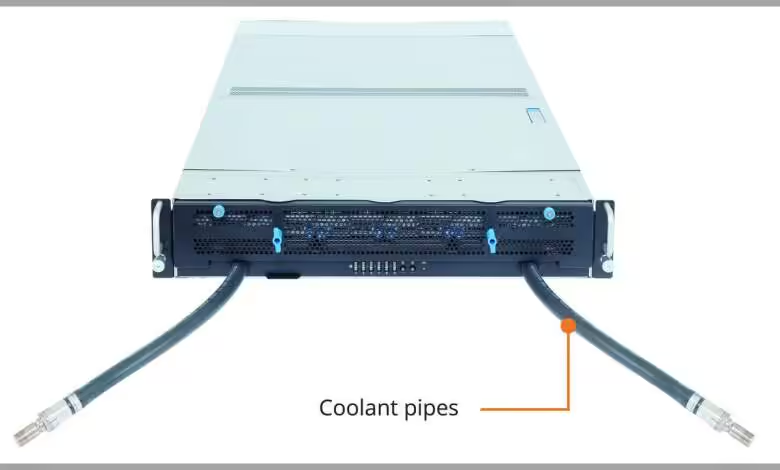

Le châssis intègre deux CPU Nvidia Grace (ARM) et quatre GPU Nvidia Blackwell, avec watercooling direct sur les composants critiques. Chaque Grace est associé à 480 Go de LPDDR5X ECC, tandis que les GPU montent jusqu’à 186 Go de HBM3E par carte. La conception modulaire permet d’augmenter la densité de calcul Blackwell sans refonte d’allée froide/chaude.

Côté réseau, le serveur s’aligne sur les fabrics Nvidia actuelles : Quantum-X800 en InfiniBand jusqu’à 800 Gb/s par port, ou Spectrum-X en Ethernet jusqu’à 400 Gb/s. L’objectif est clair : réduire la latence inter-nœuds tout en maintenant des débits soutenus pour l’entraînement distribué et l’inférence à grande échelle.

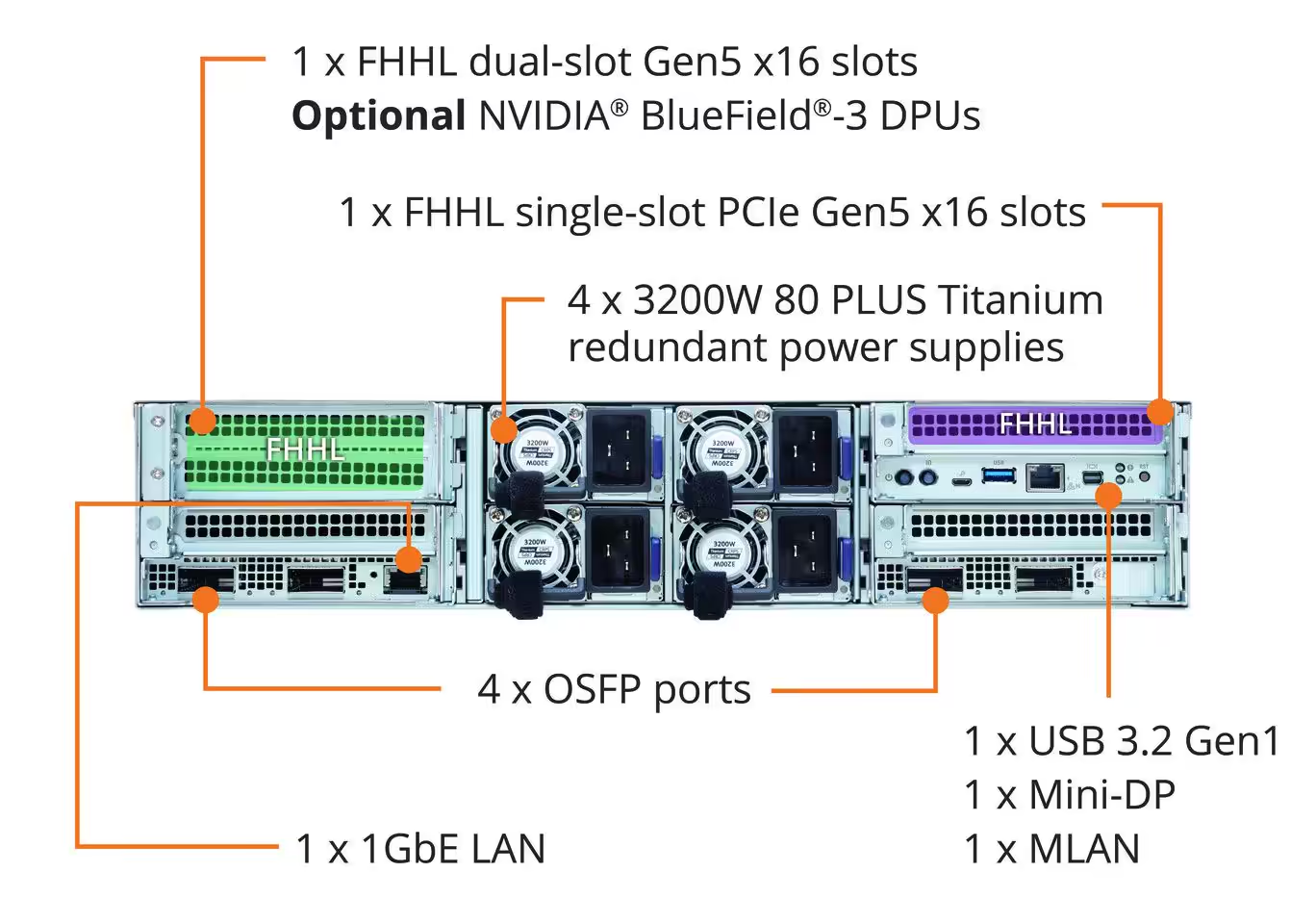

Stockage PCIe Gen5 et DPU en option

Jusqu’à 12 emplacements NVMe PCIe 5.0 sont disponibles pour le stockage local haute performance. Des DPU Nvidia BlueField peuvent être ajoutés pour le déchargement réseau/sécurité et l’isolement des flux, utile en multi-tenant ou pour la télémetry à large échelle. L’alimentation redondante certifiée 80 Plus Titanium sécurise la continuité en pleine charge.

Le positionnement est sans ambiguïté : offrir une brique compacte 2U capable de délivrer des perfs Blackwell en environnement data center existant, avec une enveloppe thermique maîtrisée grâce au DLC. Dans la course aux clusters AI hautement maillés, cet assemblage Grace + Blackwell + X800/Spectrum-X coche les cases d’échelle, d’efficacité énergétique et de débit est-ouest, tout en réduisant la dette d’intégration côté thermique.

Source : ITHome