NVIDIA Rubin s’avance plus vite que prévu : à l’occasion du CES 2026, la firme détaille la pile data center autour de sa nouvelle génération GPU et CPU, avec le rack Vera Rubin NVL72 en tête d’affiche.

NVIDIA Rubin NVL72 en détails

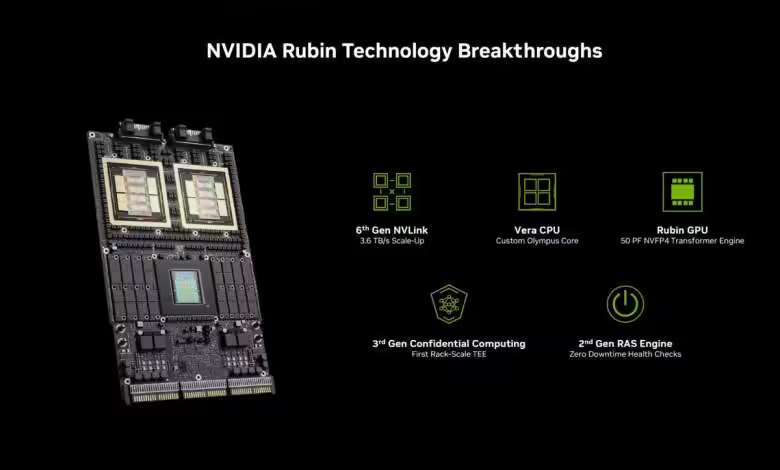

Au cœur de l’offre, le GPU Rubin revendique 336 milliards de transistors et une conception à deux dies de réticule. Les chiffres avancés montent jusqu’à 50 PFLOPS en NVFP4 pour l’inférence et 35 PFLOPS en NVFP4 pour l’entraînement, soit, d’après NVIDIA, des gains d’un facteur 5 et 3,5 face à Blackwell. La mémoire passe en HBM4, jusqu’à 288 Go par GPU pour une bande passante cumulée pouvant atteindre 22 TB/s.

Côté CPU, Rubin s’adosse au processeur Vera, 227 milliards de transistors, basé sur des cœurs Arm « Olympus » conçus par NVIDIA. Le Vera aligne 88 cœurs et 176 threads via Spatial Multi-Threading, jusqu’à 1,5 To de LPDDR5x (SOCAMM) et 1,2 TB/s de bande passante mémoire. La cohérence NVLink-C2C grimpe à 1,8 TB/s. NVIDIA évoque des gains doublés en traitement de données, compression et CI/CD face à Grace.

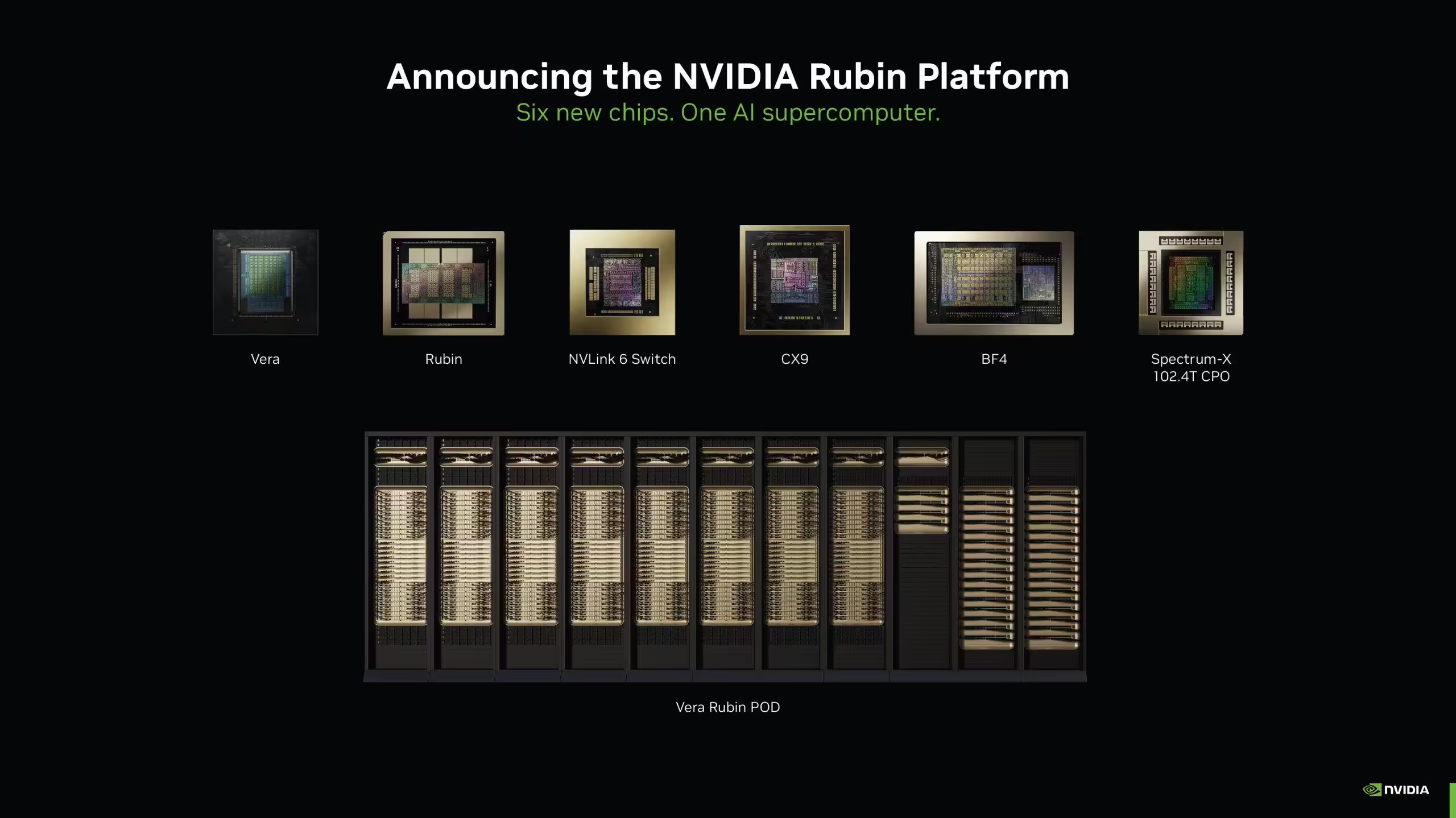

Pour le scale-up, NVLink 6 annonce 3,6 TB/s de bande passante bidirectionnelle par GPU et 260 TB/s à l’échelle du rack NVL72. Le switch NVLink 6 s’intègre au tissu de calcul avec 28,8 TB/s de bande passante totale et jusqu’à 14,4 TFLOPS FP8 de compute réseau par tiroir de switch. Pour le scale-out, ConnectX-9 et BlueField-4 prennent le relais : jusqu’à 1,6 Tb/s par GPU Rubin pour le premier, et 800 Gb/s côté DPU pour le second. Le volet Ethernet photonics s’appuie sur Spectrum-6 et un backbone à 102,4 Tb/s avec optiques co-intégrées.

Vera Rubin NVL72 : chiffres clés et efficacité annoncée

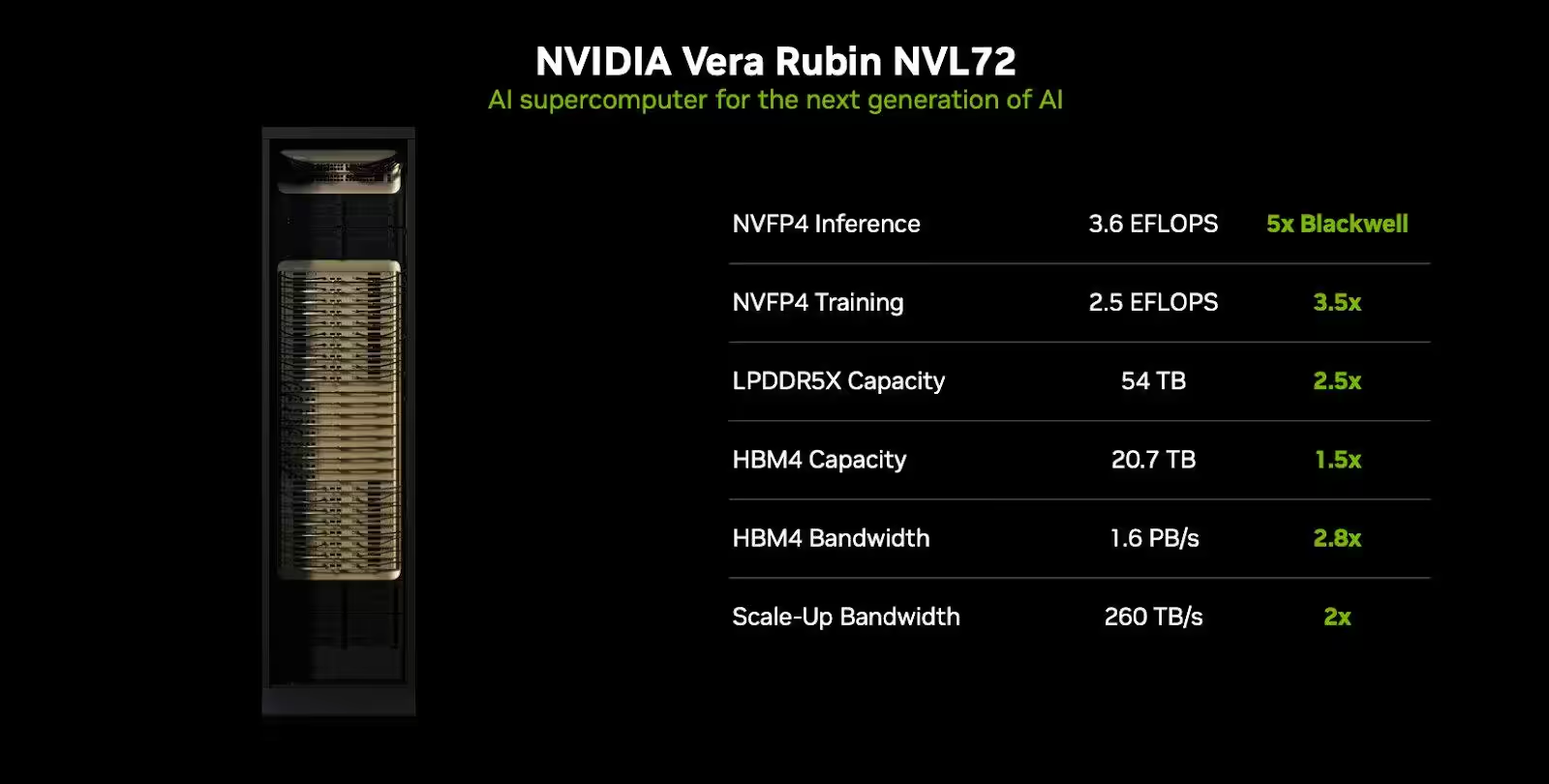

La configuration phare, Vera Rubin NVL72, agrège 72 GPU Rubin et 36 CPU Vera via NVLink 6. NVIDIA avance 3,6 EFLOPS en NVFP4 pour l’inférence et 2,5 EFLOPS pour l’entraînement, complétés par 20,7 To de HBM4 et 54 To de LPDDR5x, pour une bande passante HBM cumulée de 1,6 PB/s. Sur l’efficacité, la société lie Rubin à de fortes baisses des coûts IA : jusqu’à 10x de réduction du coût par token en inférence et 4x moins de GPU pour l’entraînement MoE par rapport à Blackwell. Un support de présentation situe aussi l’inférence MoE à environ un septième du coût par token face à GB200.

La disponibilité s’accélère : NVIDIA indique une production complète dès le premier trimestre 2026, alors que les indications précédentes tablaient sur un volume au second semestre 2026. Les partenaires resteraient servis au second semestre 2026, avec des déploiements début 2026 chez AWS, Google Cloud, Microsoft et Oracle Cloud, ainsi que via des NVIDIA Cloud Partners comme CoreWeave, Lambda, Nebius et Nscale. « Rubin est déjà en production en Q1 2026 », affirme NVIDIA.

Source : NVIDIA