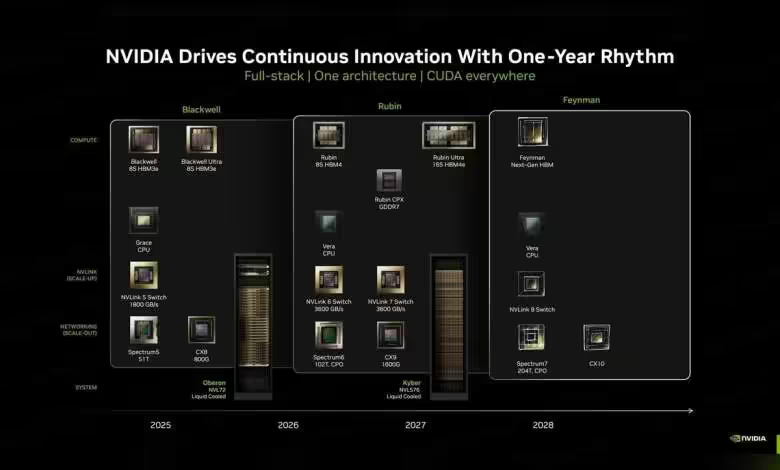

NVIDIA avance ses pions chez Intel Foundry, avec à la clé un GPU d’IA « Feynman » où TSMC reste central mais pas seul. Une bascule industrielle qui prépare les volumes de 2028 et la montée en gamme mémoire.

NVIDIA Feynman en 2028, TSMC au cœur, Intel en support

Le prochain GPU d’IA « Feynman » utilisera majoritairement des dies en TSMC A16 (1,6 nm), qui représenteraient environ 75% de la valeur du composant. Le reste des éléments silicium serait confié aux nœuds Intel 18A et 14A, avec un packaging final assuré sur le sol américain par Intel Foundry.

Selon DigiTimes, NVIDIA compte aussi s’appuyer sur l’EMIB d’Intel pour l’interconnexion chiplet. Le lancement de Feynman est attendu en 2028, en succession de Rubin, et intervient alors que NVIDIA a récemment pris environ 5% du capital d’Intel.

EMIB, 18A/14A et packaging US : la brique Intel

Intel assurerait le bonding EMIB et une partie des composants sur 18A ou 14A, un découplage qui sécurise l’approvisionnement et diversifie les risques de capacité. Le packaging final aux États-Unis ajoute un argument « onshore » pour des déploiements hyperscale sensibles.

Feynman viserait une mémoire nouvelle génération, HBM4e voire HBM5, avec une capacité par package en forte hausse pour traiter des modèles au trillion de paramètres. La chaîne TSMC/Intel conditionnera la tenue des calendriers et la disponibilité en volume.

Mémoire et échelle modèle

L’adoption de HBM4e/HBM5 et l’augmentation de la mémoire par module ciblent explicitement les charges de travail XXL. L’objectif: aligner bande passante et capacité pour des entraînements et inférences de modèles à mille milliards de paramètres.

Si Intel réussit l’exécution 18A/14A et un packaging EMIB en volumes, ce montage TSMC-majoritaire + Intel pourrait devenir un standard pragmatique du haut de gamme IA, où la spécialisation des nœuds et l’assemblage avancé dictent le rythme plus que le « tout chez un seul fondeur ».

Source : TechPowerUp