NVIDIA CUDA 13.1 inaugure CUDA Tile, un nouveau modèle de programmation par « tuiles » qui promet d’abstraire les Tensor Cores et de simplifier l’écriture d’algorithmes hautes performances sur GPU.

CUDA Tile, une couche plus haut niveau que le SIMT

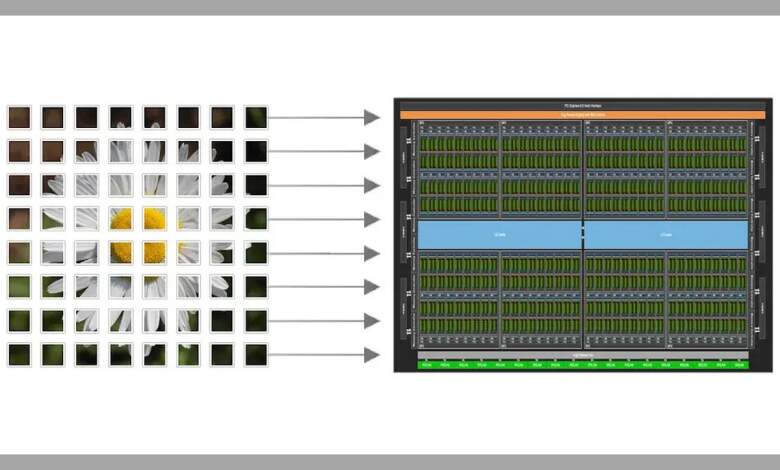

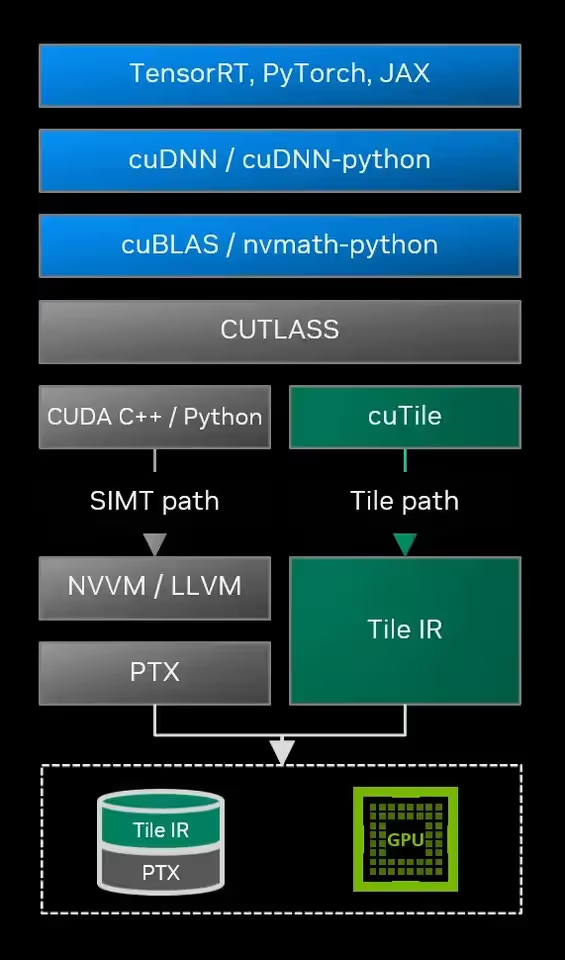

Présenté comme l’évolution la plus marquante depuis 2006, CUDA Tile apporte une représentation intermédiaire dédiée, baptisée CUDA Tile IR, et un ensemble d’instructions virtuelles pour programmer des opérations « par tuiles ». L’idée : décrire des blocs de données et les calculs associés, tandis que le compilateur et l’exécution se chargent du mapping fin sur le matériel, y compris la hiérarchie mémoire et les Tensor Cores.

Historiquement, CUDA expose un modèle SIMT très flexible mais exigeant côté optimisation. Ici, NVIDIA vise à élever le niveau d’abstraction, en phase avec l’essor des charges IA où les tenseurs dominent. D’après l’annonce, « CUDA Tile abstrait les Tensor Cores et leurs modèles de programmation » afin que le même code tuilé reste compatible avec les architectures actuelles et futures.

Important : ce n’est pas un choix exclusif. Les deux voies coexistent : on continue d’écrire des kernels SIMT quand c’est pertinent, et on bascule vers des kernels tuilés pour exploiter au mieux les unités spécialisées comme les Tensor Cores et les accélérateurs mémoire TMA.

CUDA Tile IR et outils : de l’IR aux bibliothèques Python

Au cœur du dispositif, CUDA Tile IR joue pour la programmation par tuiles un rôle analogue à PTX pour le SIMT : portabilité et exécution efficace sur plusieurs générations de GPU, avec la possibilité de bâtir des compilateurs, frameworks et langages dédiés au-dessus.

La plupart des développeurs n’auront cependant pas à manipuler l’IR : NVIDIA propose cuTile Python, qui s’appuie sur CUDA Tile IR en backend. Pour les concepteurs d’outils ou bibliothèques ciblant déjà PTX, il est possible d’étendre la chaîne pour viser aussi CUDA Tile IR. L’ensemble est disponible dès CUDA 13.1, avec documentation, dépôts GitHub et exemples sur la page officielle.

À retenir : CUDA Tile permet de décrire des calculs par blocs de données sans micro-gérer les threads, abstrait les Tensor Cores pour une compatibilité pérenne, et coexiste avec le SIMT pour préserver la liberté d’optimisation.

Source : TechPowerUp