Nemotron 3 Nano frappe fort : NVIDIA annonce un modèle open‑weight de 30B avec une fenêtre de contexte native d’un million de tokens. Destiné aux flux multi‑agents et aux outils, Nemotron 3 Nano mise sur un débit de tokens élevé et une architecture MoE hybride Mamba‑Transformer.

Nemotron 3 Nano : 30B au total, 1M de contexte, MoE hybride

NVIDIA présente un modèle à experts mixtes où 30 milliards de paramètres totaux côtoient environ 3 milliards actifs par token, tandis que la fiche Hugging Face précise 31,6B au total et près de 3,6B actifs. Le routeur activerait 6 experts sur 128 à chaque passe, d’après Hugging Face, avec des cibles de déploiement annoncées sur DGX Spark, H100 et B200.

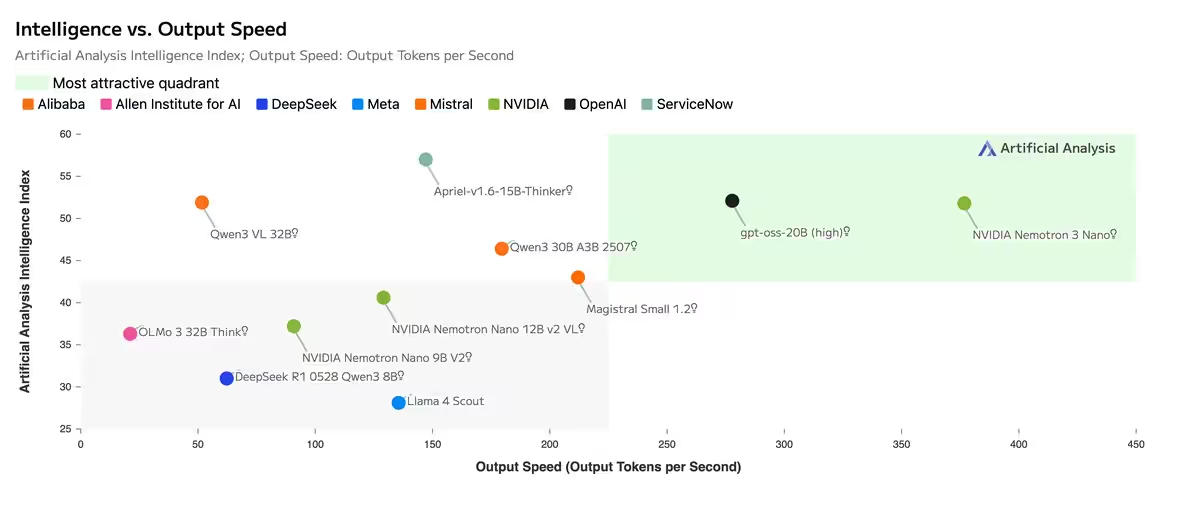

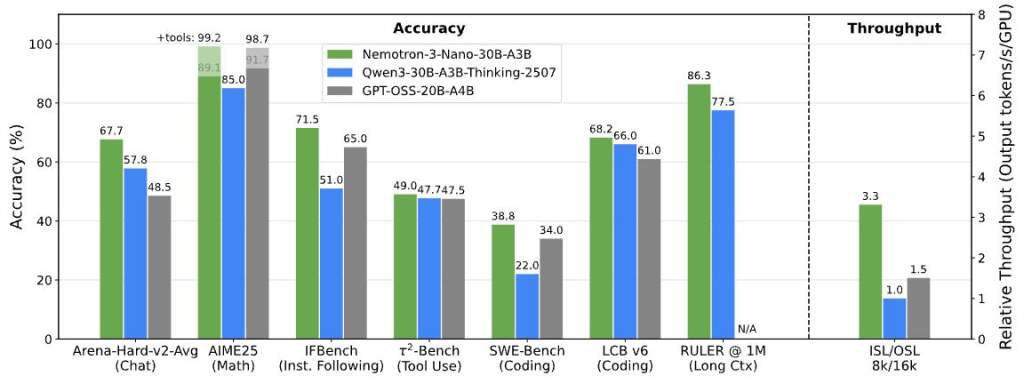

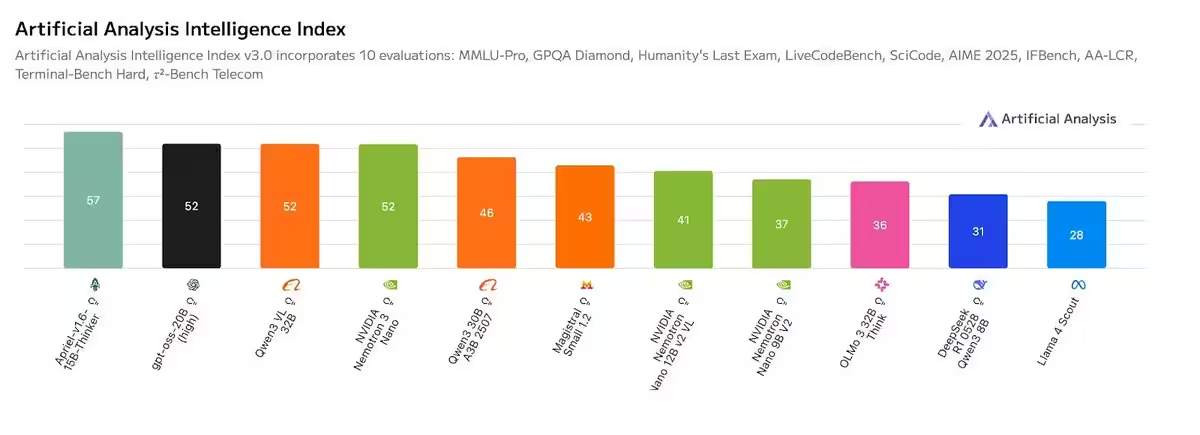

Côté performances, Hugging Face revendique jusqu’à 4 fois plus rapide en inférence que Nemotron Nano 2, et jusqu’à 3,3 fois plus de throughput que d’autres modèles de taille similaire. Un exemple sur un seul GPU H200, en configuration entrée 8K et sortie 16K, crédite Nano d’un débit 3,3 fois supérieur à Qwen3‑30B et 2,2 fois supérieur à GPT‑OSS‑20B. NVIDIA cite aussi Artificial Analysis : Nano obtiendrait 52 à l’Intelligence Index v3.0 parmi les modèles comparables.

La fenêtre de contexte constitue l’autre indicateur clé : 1M de tokens. La note Hugging Face décrit une extension long contexte via un entraînement continu à 512K de longueur de séquence, mélangé à des séquences plus courtes pour préserver les performances sur benchmarks court contexte. NVIDIA met en avant la prise en charge de vastes bases de code, de documents longs et de sessions d’agents prolongées sans fractionnement lourd : « support pour de longs documents et sessions agents sans chunking massif », résume la société.

Outils, cibles GPU et feuille de route Nemotron 3

Pour le déploiement, NVIDIA fournit des cookbooks pour vLLM, SGLang et TensorRT‑LLM, et mentionne une exécution sur GeForce RTX via llama.cpp et LM Studio. La feuille de route annonce Nemotron 3 Super et Ultra au premier semestre 2026, avec au programme latent MoE, multi‑token prediction et entraînement NVFP4. En contexte, la famille Nemotron‑3 8B (2023) visait surtout le chat et la FAQ en entreprise via NeMo et des catalogues hébergés.

Verdict

Avec Nemotron 3 Nano, NVIDIA ne se contente pas de publier un modèle open-weight de plus. Le constructeur pose un jalon clair dans sa stratégie IA : proposer des modèles pensés dès l’origine pour les flux multi-agents, les outils et les contextes extrêmement longs, tout en les intégrant étroitement à son écosystème matériel et logiciel. Le million de tokens natif, l’architecture MoE hybride et les optimisations d’inférence ciblées renforcent cette approche verticale, où le modèle devient un prolongement naturel de la plateforme NVIDIA.

En face, AMD joue une partition différente. Le fondeur mise avant tout sur son matériel Instinct et sur un écosystème ouvert capable de faire tourner les meilleurs modèles du moment, sans chercher à imposer une famille de modèles maison équivalente. Cette opposition de philosophies dessine deux visions du marché : NVIDIA avance avec des solutions clés en main, tandis qu’AMD privilégie la flexibilité et l’interopérabilité.

Reste à voir si cette intégration poussée des modèles par NVIDIA deviendra un standard pour les usages agents et long contexte, ou si l’écosystème open source, soutenu par des plateformes comme celles d’AMD, saura combler cet écart sans dépendre d’un acteur unique. Les prochaines déclinaisons Nemotron 3 Super et Ultra, attendues en 2026, devraient rapidement apporter des éléments de réponse.

Source : blogs.nvidia.fr