« DeepSeek-V3 est construit sur notre architecture. » La phrase d’Arthur Mensch, CEO et cofondateur de Mistral, a déclenché un tir de barrage. Dans un entretien récent sur la dynamique de l’open source en Chine, le dirigeant a décrit Mixtral comme le premier « sparse Mixture-of-Experts » maison publié début 2024 et affirmé que DeepSeek-V3 et ses itérations s’appuyaient sur la même architecture, rendue reproductible par Mistral.

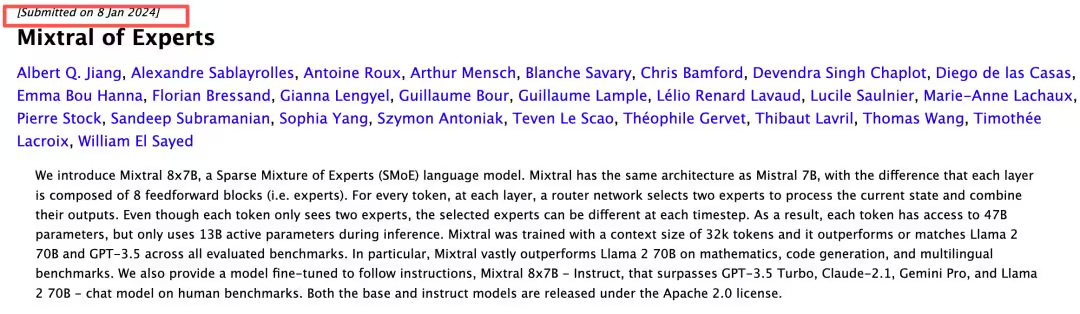

La chronologie et la technique compliquent toutefois ce récit. Les deux papiers fondateurs sont apparus à trois jours d’intervalle sur arXiv (Mixtral: 2401.04088 ; DeepSeek: 2401.06066), tous deux axés sur les SMoE avec activation clairsemée pour réduire le coût de calcul et améliorer les performances.

Mais les objectifs divergent : Mixtral procède d’une approche d’ingénierie visant à montrer qu’un socle solide + un MoE éprouvé peut dépasser des denses plus grands, quand DeepSeek revendique une refonte de l’architecture pour traiter deux angles morts du MoE classique, la surcharge de compétence des experts et les redondances d’apprentissage.

Deux voies pour le SMoE

Les deux utilisent un routage Top-K façon GShard. Mixtral conserve une granularité standard : chaque expert est un bloc FFN complet, tous considérés à parité, sélectionnés dynamiquement par le routeur. La distribution des connaissances y reste relativement plate, mêlant généraliste et spécifique au sein des mêmes experts.

DeepSeek introduit une segmentation fine des experts, découpant de « gros » experts en unités plus petites à paramètres constants, pour des combinaisons plus flexibles et un apprentissage plus ciblé. S’y ajoutent des « experts partagés », toujours activés et exclus du routage, qui encapsulent les compétences générales, pendant que les experts soumis au Top-K se spécialisent. Résultat : un découplage explicite des connaissances générales et spécifiques, absent du design Mixtral.

Autre point qui alimente la controverse : la publication « Mixtral of Experts » ne détaille ni données, ni hyperparamètres, ni tokens d’entraînement, ni ablations. À l’inverse, la communauté a relevé fin 2025 que Mistral 3 Large reprenait le schéma architectural popularisé par DeepSeek-V3, renversant de fait l’argument d’antériorité suggéré par Arthur Mensch.

Open source, influence et récit d’antériorité

Sur le fond, l’affirmation d’un « même type d’architecture » tient pour le cadre SMoE/Top-K. Sur les choix structurants, elle s’effrite. L’impact industriel penche aujourd’hui du côté de DeepSeek, dont les contributions sur le MoE clairsemé et la MLA ont marqué l’écosystème, quand Mistral a surtout installé Mixtral comme référence opérationnelle et catalyseur de l’adoption. Au-delà du bruit, le différentiel d’influence technique s’est déplacé, et la bataille d’image autour de l’antériorité reflète la tension entre itération d’ingénierie et réagencement algorithmique.

Dans un marché où la performance/coût sur GPU devient l’axe cardinal, la granularité des experts, le rôle d’experts partagés et la discipline de routage ne sont pas des détails : ils conditionnent l’efficacité d’entraînement, la stabilité et l’utilisation mémoire. La prochaine salve se jouera moins dans les déclarations que dans les courbes de perplexité, la qualité des ablations et les gains visibles en production, alors que DeepSeek prépare déjà une nouvelle fenêtre de tir.

Source : ITHome