Trois fois plus rapide que Trainium v3 en FP4, au-dessus de TPU v7 en FP8: la nouvelle puce IA de Microsoft vise l’inférence à grande échelle et la facture cloud.

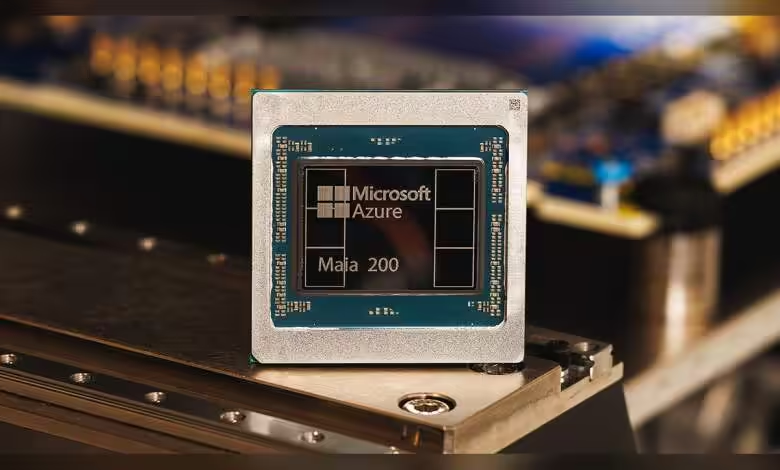

Microsoft Maia 200: cap sur l’inférence rentable

Gravée en 3 nm chez TSMC, Maia 200 aligne plus de 140 milliards de transistors, des Tensor Cores natifs FP8/FP4 et un sous-système mémoire repensé: 216 GB de HBM3e à 7 TB/s et 272 MB de SRAM on‑chip. Le SoC cible 750 W de TDP avec plus de 10 petaFLOPS en FP4 et plus de 5 petaFLOPS en FP8.

Microsoft annonce 30% de performance par dollar en mieux vs sa génération actuelle et revendique « le plus performant » des siliciums propriétaires de hyperscaler. L’accélérateur nourrit les plus gros modèles d’aujourd’hui et anticipe des tailles supérieures.

La mémoire s’articule autour de types de données étroits, d’un DMA spécialisé, d’une SRAM intégrée et d’un NoC dédié au débit, pour maximiser le throughput de tokens. Côté comparaison, Microsoft évoque un ratio 3× la perf FP4 d’Amazon Trainium de 3e génération et une perf FP8 au‑dessus de la 7e génération de TPU de Google.

Intégration Azure et écosystème logiciel

Maia 200 s’intègre à Azure et arrive avec un SDK en préversion: intégration PyTorch, compilateur Triton, librairie de kernels optimisés et un langage bas niveau pour un contrôle fin. Objectif: portage facile entre accélérateurs hétérogènes, sans sacrifier les optimisations ciblées.

Les déploiements démarrent en région US Central (près de Des Moines, Iowa), puis US West 3 (Phoenix, Arizona), d’autres régions suivront. Les workloads ciblés incluent les modèles GPT‑5.2 d’OpenAI pour Foundry et Microsoft 365 Copilot, ainsi que les pipelines de données synthétiques et le RL du groupe Superintelligence.

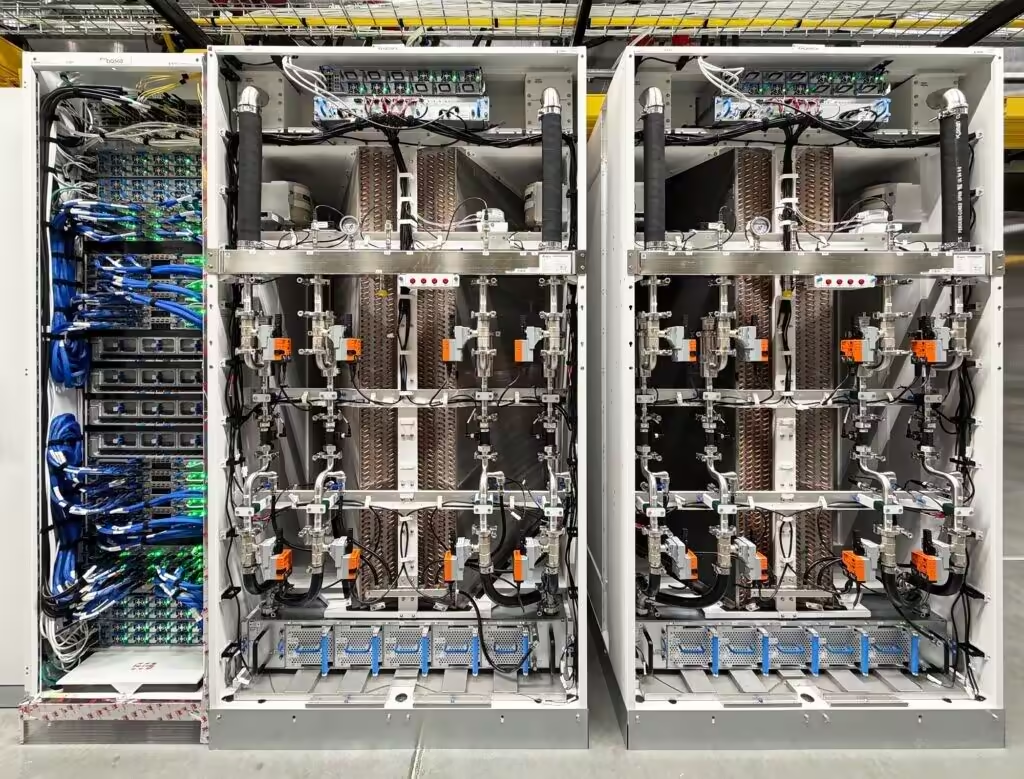

Réseau scale‑up sur Ethernet et efficacité datacenter

Le système introduit un réseau scale‑up à deux niveaux basé sur Ethernet standard: couche de transport maison, NIC intégrée, bande passante bidirectionnelle dédiée de 2,8 TB/s par accélérateur. Les opérations collectives sont annoncées prévisibles jusqu’à 6 144 accélérateurs.

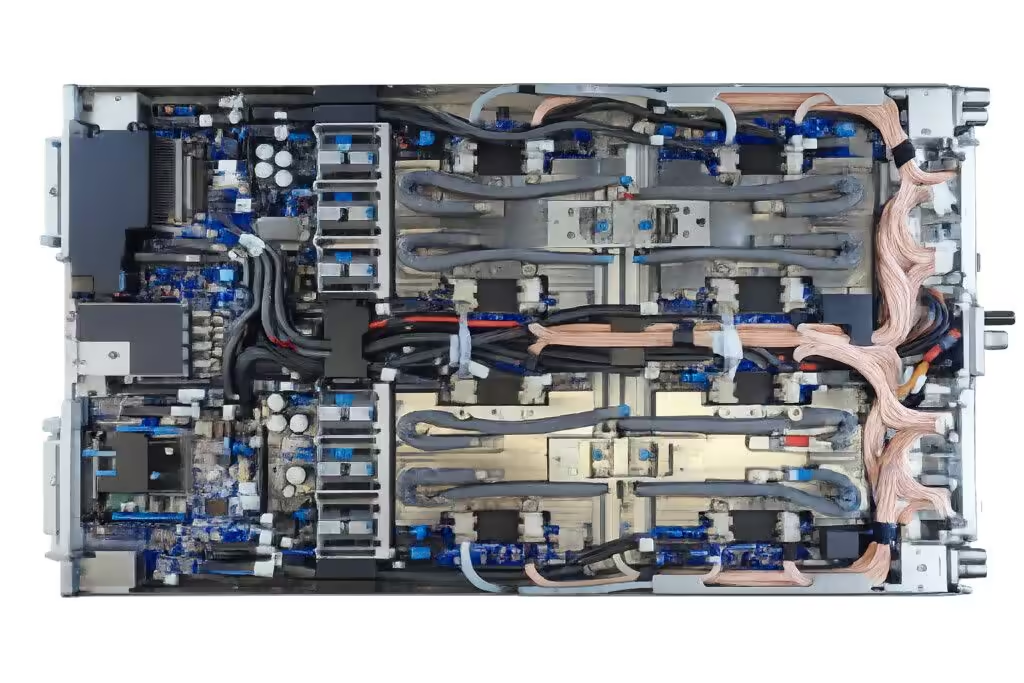

Dans chaque tray, quatre Maia sont reliés en direct sans switch pour garder le trafic à haut débit local. Le protocole de transport Maia s’étend intra‑rack et inter‑rack avec peu de sauts, simplifiant le dev et réduisant la capacité perdue. L’approche vise un meilleur TCO et une consommation contenue à l’échelle du cloud.

Cycle de validation et mise en production

Microsoft a simulé tôt les charges LLM pour co‑optimiser silicium, réseau et logiciel, avec un passage au rack deux fois plus rapide que sur des programmes comparables. Les modèles tournaient quelques jours après l’arrivée des premiers packages, aidés par une intégration native au plan de contrôle Azure, une télémétrie complète et un refroidissement liquide à boucle fermée de seconde génération.

Si Microsoft tient ses promesses de perf/$ et d’échelle sur Ethernet, Maia 200 pourrait bousculer la prime aux fabrics propriétaires dans l’inférence dense, tout en renforçant l’avantage coût/latence d’Azure sur les services Copilot et les pipelines de données synthétiques. Reste à voir l’élasticité réelle à 6 144 accélérateurs sur des charges mixtes et la cadence de déploiement par région.

Source : TechPowerUp