FuriosaAI passe à la vitesse supérieure : la société coréenne annonce la mise en production de son accélérateur d’inférence de seconde génération, RNGD. Les premiers 4000 systèmes ont été livrés par TSMC et Asus, signe que la chaîne d’industrialisation est en place et que l’offre vise une disponibilité immédiate pour les data centers existants.

Spécifications et positionnement

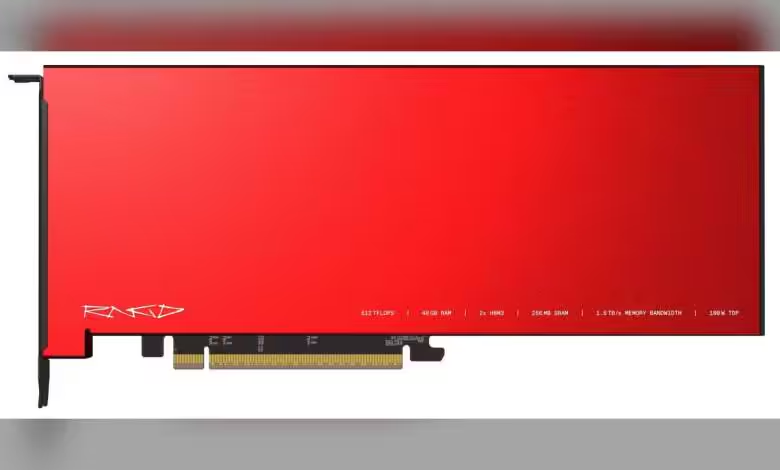

Gravé en 5 nm chez TSMC, le RNGD combine 256 Mo de cache SRAM on-die et deux piles de HBM3, soit 48 Go au total. FuriosaAI annonce jusqu’à 512 TOPS en INT8 pour un TDP de 180 W, un ratio performance/consommation taillé pour les baies à refroidissement par air et les contraintes d’alimentation modestes.

La cible est claire : l’inférence de grands modèles, avec la prise en charge de GPT-OSS 120B (en configuration bi-carte) et de Qwen 2.5 entre autres. L’écosystème se décline en deux produits : une carte PCIe AIC autonome et un serveur 4U « clé en main » NXT RNGD intégrant huit cartes.

Déploiement et usage

Avec 180 W par carte, le RNGD vise des salles sans watercooling, où l’intégration de GPU/ASIC haut TDP est souvent bloquée par l’enveloppe thermique et électrique. La configuration 8× AIC en 4U suggère un focus sur la densité et la latence mémoire, la HBM3 de 48 Go par carte offrant un tampon confortable pour des variantes quantifiées de LLMs.

Le partenariat industriel avec Asus pour les plateformes et TSMC pour la fab conforte une montée en charge crédible. Reste la question logicielle, déterminante pour l’adoption face aux piles CUDA/Rocm, que FuriosaAI devra éclairer rapidement pour convertir l’intérêt en déploiements en production.

Source : ITHome