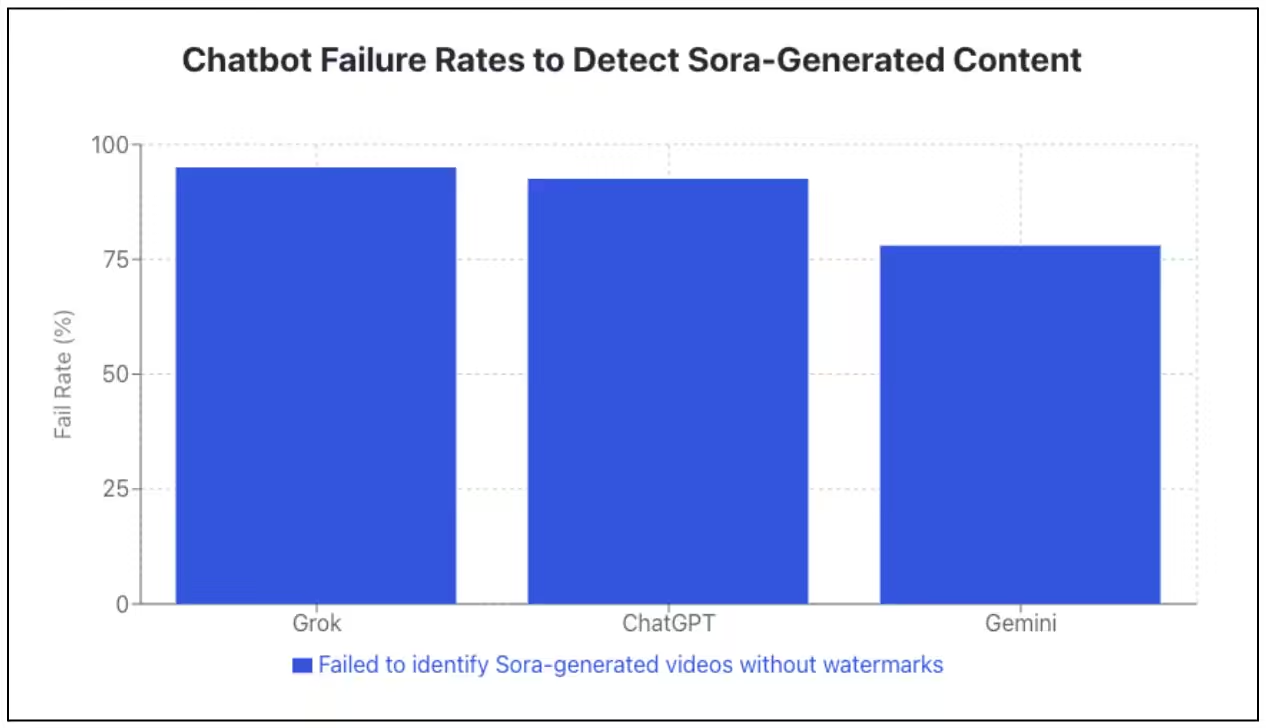

Selon une enquête de Newsguard, les principaux chatbots peinent à détecter les vidéos générées par IA. Testés sur des séquences produites avec Sora, l’outil vidéo d’OpenAI, Grok d’xAI échoue sur 95 % des cas, ChatGPT atteint 92,5 % d’erreurs, et Gemini de Google reste le « meilleur » du lot avec 78 % d’erreurs. Le protocole inclut des questions directes sur l’authenticité des vidéos et sur leur éventuelle origine IA.

Des garde-fous facilement contournés

Sora appose un filigrane visible « Sora » en mouvement et embarque aussi des métadonnées C2PA pour la traçabilité. Dans les faits, ces dispositifs sont fragiles. Des outils gratuits en ligne suppriment le filigrane sans effort. Newsguard en a employé un pour ses tests, ce qui a suffi à tromper les modèles.

Même avec filigrane intact, les chatbots se trompent encore. Sur des vidéos marquées, Grok échoue dans 30 % des cas, ChatGPT dans 7,5 %, quand Gemini les identifie correctement à 100 %. Newsguard cite des réponses fantaisistes, dont une attribution à un inexistant « Sora News » au sujet d’une livraison fictive de chasseurs du Pakistan à l’Iran.

Le marquage C2PA n’est pas mieux loti. Les métadonnées sont conservées via le bouton de téléchargement de Sora, mais disparaissent avec un simple « Enregistrer sous ». Plus embarrassant, Newsguard note que ChatGPT (version testée présentée comme GPT-5.2) a nié l’existence de métadonnées C2PA pourtant présentes.

Des réponses assurées, rarement nuancées

Les systèmes testés préviennent très peu leurs utilisateurs de leurs limites de détection. D’après les mesures, ChatGPT ne le mentionne que dans 2,5 % des échanges, Gemini dans 10 % et Grok dans 13 %. À l’inverse, ils délivrent souvent des jugements catégoriques mais erronés, y compris sur des vidéos politiques fabriquées de toutes pièces (ICE arrêtant un enfant, employé Delta expulsant un passager pour une casquette « MAGA »), données comme authentiques par les trois bots.

Interrogé par Newsguard, OpenAI indique que ChatGPT « n’a pas la capacité de déterminer si un contenu est généré par IA », sans expliquer pourquoi cette limite n’est pas systématiquement communiquée. Google revendique une approche différente avec SynthID, un marquage imperceptible conçu pour survivre à des retouches. Gemini reconnaît ainsi ses propres images Nano Banana Pro même sans filigrane, mais Google admet que ce mécanisme ne généralise pas aux contenus de Sora ni d’autres fournisseurs.

Le tableau a des implications claires pour l’écosystème: les générateurs vidéo comme Sora 2 ou Veo 3 franchissent un palier de photoréalisme, mais l’outillage de détection et de traçabilité reste parcellaire, propriétaire et aisément neutralisable. À court terme, l’absence d’interopérabilité des marquages, la volatilité des métadonnées et la communication parcimonieuse des limites des chatbots créent un risque double: accélération des campagnes de désinformation et « validation » erronée par des assistants grand public. Sans standard robuste et universellement appliqué côté génération comme côté lecture, la chaîne de confiance ne tient pas.

Source : ITHome