d-Matrix change de braquet dans l’inférence IA pour datacenters en s’alliant à Alchip : les deux entreprises développent un accélérateur s’appuyant sur de la DRAM empilée en 3D, avec à la clé des gains de performance et de coûts présentés comme décisifs face aux limites actuelles des infrastructures IA.

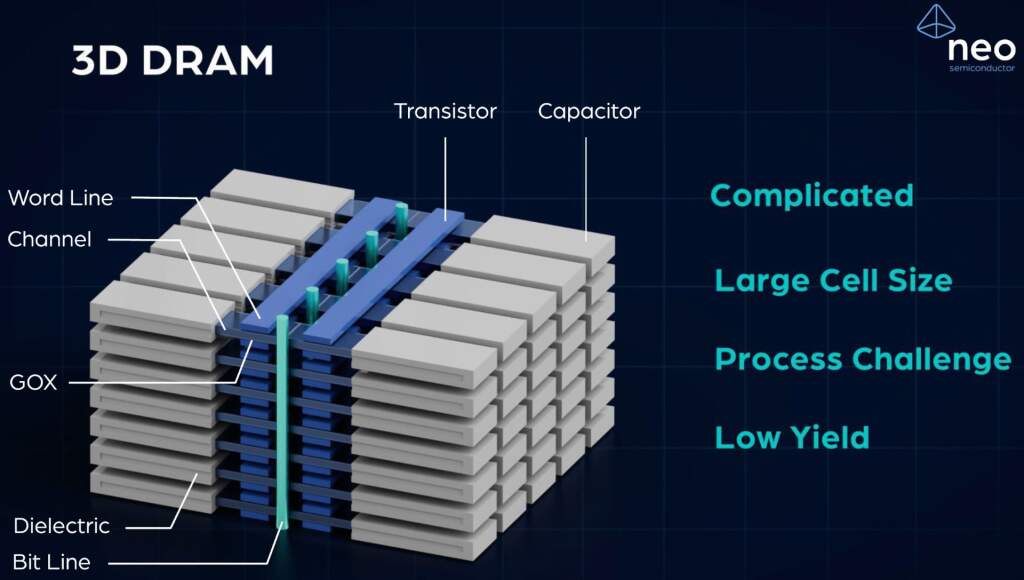

Un accélérateur d’inférence en DRAM 3D pour contourner les goulots d’étranglement

Le projet marie l’expertise ASIC d’Alchip et l’architecture de calcul en mémoire de d-Matrix. Au cœur du dispositif, la technologie 3DIMC de d-Matrix, déjà intégrée au test silicon Pavehawk et validée en laboratoire, doit faire ses débuts commerciaux sur l’accélérateur Raptor, successeur du Corsair.

D’après d-Matrix, cette première solution d’inférence basée sur DRAM 3D pourrait offrir jusqu’à 10 fois plus de performances que des solutions reposant sur HBM4, une promesse qui cible directement les charges d’IA générative et agentique. L’ambition est claire : réduire les coûts et la consommation tout en supprimant les goulots d’étranglement entre calcul et mémoire.

« À d-Matrix, nous pensons que l’efficacité de l’IA exige de repenser l’articulation entre calcul et mémoire », rappelle Sid Sheth, cofondateur et PDG de d-Matrix, qui voit dans la DRAM 3D la continuité de la feuille de route initiée avec Corsair. Chez Alchip, Johnny Shen souligne une approche collaborative jugée indispensable pour concrétiser des avancées d’ampleur.

A lire : Samsung HBM4e vise 13 Gbps/pin et 3,25 To/s, production attendue fin 2025

3DIMC validé en labo, cap sur Raptor

La techno 3DIMC, déjà aperçue lors d’une présentation de Sudeep Bhoja (cofondateur et CTO de d-Matrix) à Hot Chips 2025, semble désormais en bonne voie pour une intégration commerciale sur Raptor. Aucun calendrier précis ni caractéristiques techniques détaillées ne sont communiqués, mais la stratégie vise à rapprocher calcul et mémoire pour maximiser le débit d’inférence, tout en améliorant l’efficacité énergétique et le TCO.

Reste à voir, lors de la sortie de Raptor, comment cette DRAM 3D se positionnera face aux solutions HBM4 du marché et si les gains « jusqu’à 10× » se confirment sur des workloads réels d’IA générative et d’agents.

Source : TechPowerUp