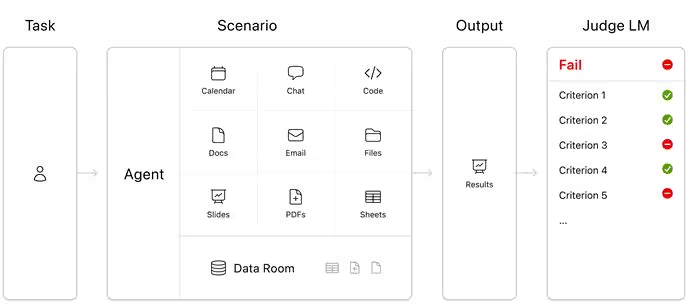

Selon une étude relayée par Digital Trends et menée par Mercor, les grands modèles d’IA peinent à exécuter des tâches de bureau réalistes : aucun ne dépasse 25 % de précision sur le nouveau benchmark APEX-Agents. Ce protocole ne teste ni poésie ni équations, mais des workflows concrets de juristes, consultants et banquiers, avec des séquences multi‑étapes faisant appel à plusieurs sources d’information.

Le meilleur score revient à Gemini 3 Flash (24,0 %), suivi de GPT‑5.2 (23,0 %). Derrière, Claude Opus 4.5 et Gemini 3 Pro affichent 18,4 %, GPT‑5 18,3 %, Grok 4 15,2 %, puis un net décrochage pour GPT‑OSS‑120B (4,7 %) et Kimi K2 Thinking (4,0 %). Ces résultats confirment la difficulté des modèles à tenir une chaîne d’actions fiable lorsqu’il faut enchaîner consultation d’agendas, historiques de messagerie, PDF et feuilles de calcul.

Contexte et limites du protocole

Mercor attribue l’échec récurrent à la gestion du contexte et au passage d’une source à l’autre, où les modèles confondent, mélangent ou abandonnent des étapes critiques. Dans un environnement de bureau, cette fragilité les cantonne au rôle d’« assistant stagiaire » peu fiable plutôt qu’à celui d’opérateur autonome. La méthodologie APEX-Agents se distingue en imposant une coordination d’outils et de supports hétérogènes, un point névralgique des usages réels que les benchmarks classiques éludent encore trop souvent.

Progrès rapides mais insuffisants

Mercor souligne néanmoins une progression marquée : des tests comparables plafonnaient à 5–10 % il y a un an, contre 24 % aujourd’hui pour le meilleur modèle. L’accélération est nette, sans pour autant valider une substitution proche des travailleurs du savoir tant que la gestion multi‑tâches et les bascules de contexte resteront instables. Pour les déploiements en production, la fiabilisation passera autant par l’orchestration outil‑par‑outil et la vérification systématique que par de nouveaux entraînements focalisés sur l’exécution et la mémoire de travail.

Source : ITHome