AMD Instinct MI355X s’invite dans l’inférence moderne avec un angle clair : accélérer les modèles de raisonnement et MoE tout en restant ouvert et reproductible.

AMD Instinct MI355X : ATOM, kernels fusionnés et montée en charge

Face à l’essor des charges GenAI et LLM (agents, outils multi-étapes, RAG), AMD mise sur trois briques resserrées : des kernels fortement optimisés pour les primitives LLM (MLA attention, experts MoE clairsemés, GEMM à l’échelle bloc) adaptés aux GPU Instinct, un moteur d’inférence léger baptisé ATOM pour l’ordonnancement, le batching et la gestion du KV-cache, et un socle distribué taillé pour le dispatch MoE, l’agrégation d’experts et le trafic KV inter-nœuds. Le moteur ATOM est open source ici : https://github.com/ROCm/ATOM/.

Sur DeepSeek-R1, modèle open source axé raisonnement combinant attention MLA et MoE sparse, AMD indique des gains nets en nœud unique et en distribué. D’après la société, « ATOM fournit la voie la plus directe vers les performances de pointe sur Instinct MI355X » pour ces architectures dominées par le MoE.

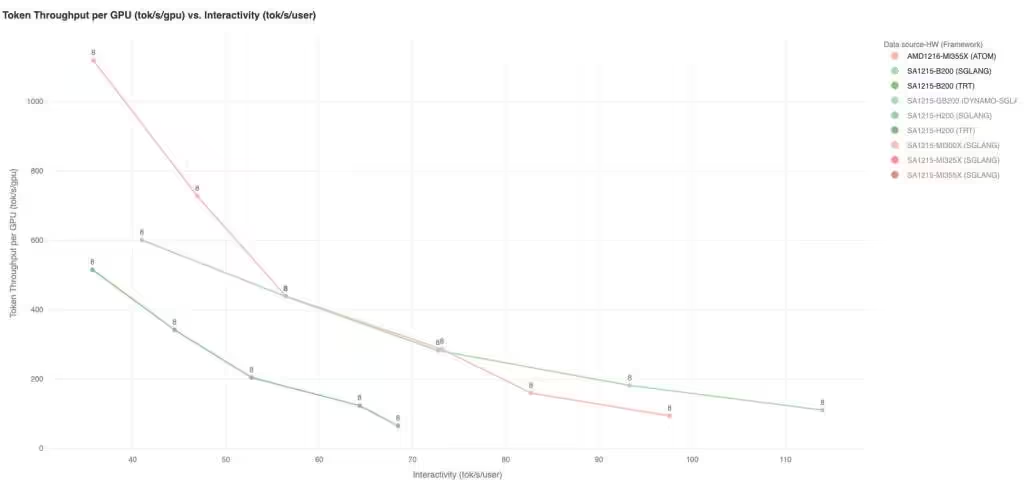

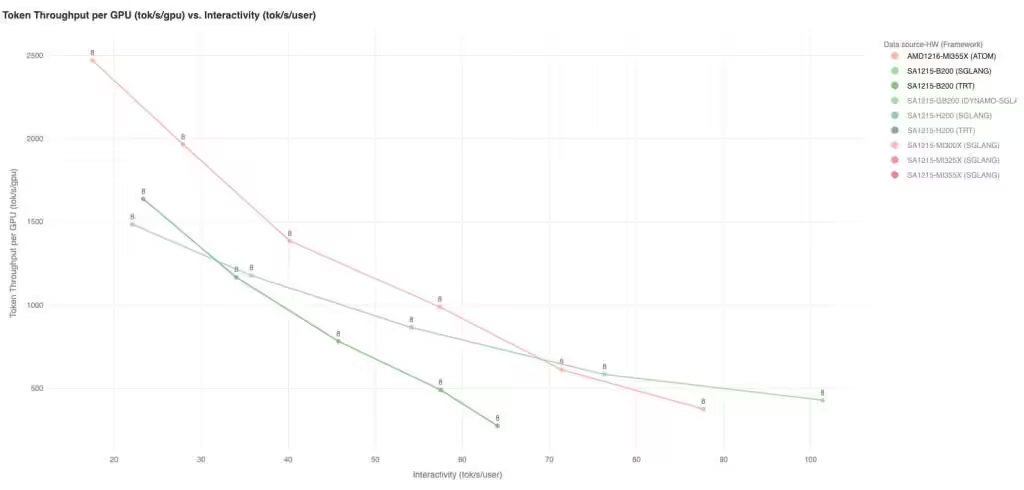

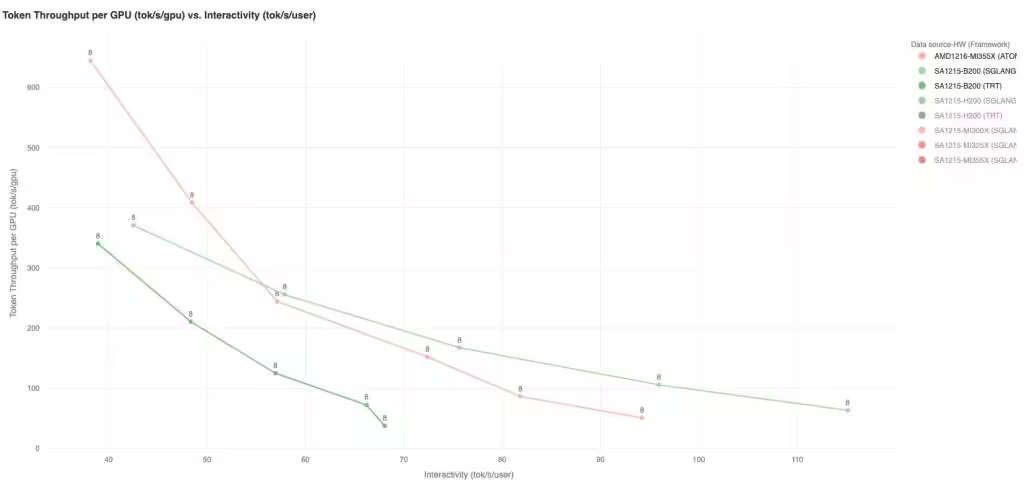

Single-node : concurrence 4 à 64, séquences 1K/1K, 8K/1K et 1K/8K

Selon AMD, le MI355X sous ATOM tient la cadence face à des systèmes NVIDIA Blackwell B200 utilisant des frameworks existants, avec un avantage plus marqué aux concurrences élevées (32 et 64), cruciales pour réduire le coût par token. Les optimisations de bas niveau (exécution MoE fusionnée, fusion de l’attention MLA, réduction des mouvements mémoire sur le pipeline) soutiennent le débit sur plusieurs profils : interactif 1K/1K, orienté débit 8K/1K et génération longue 1K/8K. Les figures communiquées par AMD couvrent R1-FP8 ISL/OSL pour ces trois configurations de séquence, et des concurrences de 4 à 64.

En parallèle des frameworks vLLM et SGLang, ATOM vise l’exploitation maximale du GPU pour ces modèles à experts clairsemés, avec un pilotage local du scheduling et du KV-cache par l’utilisateur.

Multi-nœuds : expert parallelism, agrégation efficace et trafic KV maîtrisé

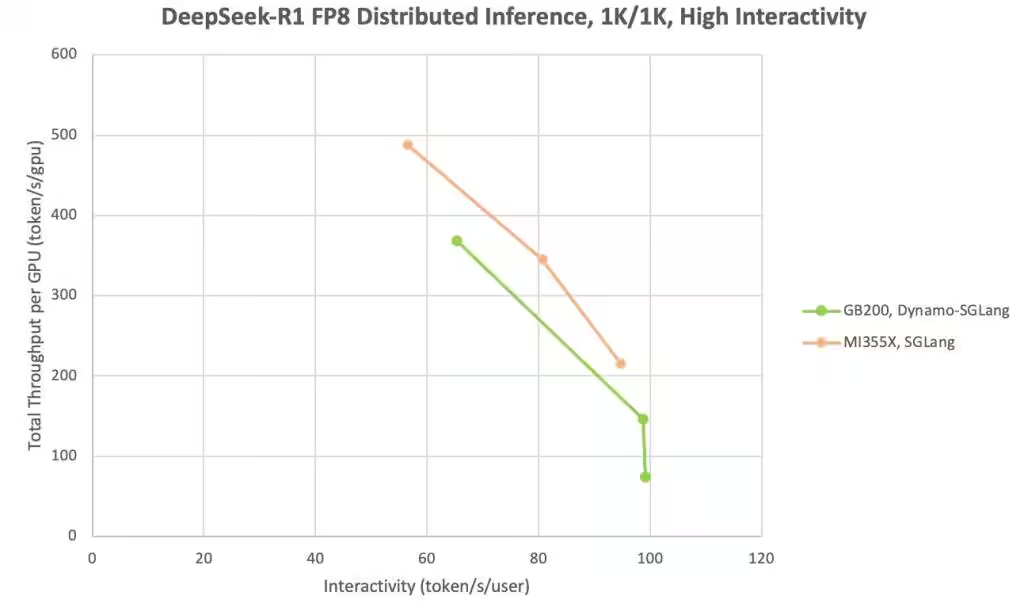

En distribué, AMD met en avant une bonne montée en charge sur les charges MoE grâce à un dispatch optimisé des experts, une agrégation efficace et une gestion soignée du KV entre nœuds. Dans un scénario sensible à la latence comme le 1K/1K ISL/OSL, une configuration 3 nœuds 1P2D, EP8 sur MI355X délivrerait, d’après AMD, un débit par GPU supérieur à NVL72 avec Dynamo tout en préservant un niveau d’interactivité comparable, utile pour les applications temps réel côté utilisateur.

Le socle distribué accepte des stratégies avancées : expert parallelism, prefill/decode disaggregation, et des optimisations pour le long contexte. AMD annonce poursuivre le travail sur l’exploration d’espaces de conception pour des configurations à experts plus larges, de nouvelles fusions d’opérateurs MoE et des améliorations d’inférence long-contexte.

Toutes les optimisations évoquées seraient upstreamées dans l’open source. Les utilisateurs peuvent reproduire et étendre les résultats, puis déployer ATOM en moteur autonome ou comme backend pour vLLM et SGLang. Note : l’analyse de performances est conduite par AMD au 18 décembre 2025 et fournie à titre informatif uniquement.

Source : TechPowerUp